序

下文来自仓颉输入法的发明人朱邦复先生,放在这里的原因是本人认为Vulkan之于汇编有着相似的地位。

一、结构基础

物质文明之有今天的成就,是因为人类掌握了物质的基本结构。物质的种类无穷,但是却都由基本元素交互组成,只要根据一定的法则,就能得到一定的结果。

计算机技术虽然日新月异,应用软件的变化也无止无尽,而其基本因子却非常有限。各种微处理器的汇编语言,正是计算机软件的基础结构,任何要通过软件以完成的动作,都是经由汇编语言的指令群,逐步执行的。

因为计算机结构复杂,各种任务分工极精,即使是一位资深的高级程序员,终其生也不过局限在若干固定的程序中钻研,很难以宏观的立场认知全貌。再加上市场压力,局外人莫名其奥妙,局中人又忙得不可开交,所以还没有任何人能作出全盘的评估。

汇编语言首先成为被误解的牺牲者,包括应用它的系统工程师在内,都一致认为它「难学难用」,(中文也是一种组合形式的应用,其所组合者是人的概念。无独有偶,人们在不求甚解之余,都视之为畏途。)事实上大谬不然,现在是科学挂帅,而科学的精义就在于系统的分类和应用。问题是我们能不能归纳出一些学习、应用的法则,将组合的过程化繁为简,以符合各种应用范畴。

二、个人体验

我个人对此感受极为深切,我原是个十足的外行,1978年第一次接触计算机,曾以不到两周的时间,就学会计算机操作,并应用「培基语言」设计完成"仓颉输入"程序。当时我认为培基语言易学易用,是计算机上最好的工具。

后来,我开始用培基语言设计"仓颉向量组字"程序,每秒可生成两个字,当时与我合作的宏碁公司建议我采用汇编语言,他们说组字程序速度要快,培基语言不能胜任。如改用汇编语言,效率可提高十倍,由此开始了我与汇编语言的不解之缘。1979年9月我们正式推出了由国人自行设计、具有完整的计算机功能、可运用数万中文字的"天龙中文计算机"。

宏碁公司动用了三位资深工程师,采用 Z80 MCZ系统,以六个月的时间完成了向量组字及系统程序,记忆空间占60KB,处理速度每秒约组成30字。

这是我首次发现到汇编语言的威力,深究之下,才理解到计算机的全部工作原理。简单说来,汇编语言就是组合计算机所有功能的控制指令,利用它,就可以直接控制计算机。

其它高级语言,只是让人省事,用一些格式化的手续,把人的想法化为过程的指令,这种情形就相当于为了迁就开车的人,建了密如蛛网的高速公路。本来走路只要几分钟就可到达的地方,以车代步的结果,反而需要耗费半个小时。

1980年,我决定自己动手,又重新设计了一套字数较多,字形较美观的组字程序。只用了三个月的时间,结果不仅记忆空间缩小了三分之一,速度也快了十倍,达到每秒 300字。这个产品,就是1苹果机上用的「汉卡」。

1983年,再经分析,我发现以往写的程序很不精简,技术也不成熟。我坚信中文字形在计算机上的应用,将是中国文化存亡兴衰的根本因素,不仅值得投注自己的时间及精力,且也有此必要。所以我又拋掉了一切,重头设计,加入更多的变化参数,并根据人的辨识原理,设计成第三代至第五代等多种字形产生器。每一代之间,速度都明显地提高,功能也不断加强。在这样一再重复的摸索中,尝试了各种可行的途径,充份认识了汇编语言的特性及长处。

由于汇编语言灵活无比的特性,我发现它就如同画家的画笔一般,只为了牟利,可以用它画成各种廉价速成的商品;一旦投入自己的理想与心智,画笔就不再只是一枝笔,而成为人心与外界的界面,画出的作品立时升华成为艺术,进入一个更高的境界!

1985年,我再次重新设计规划,采用人的智能原则,把人写字、认字的观念化为数据结构,程序只是用来阐释数据、控制计算机的界面。该字库的字形可做到无级次放大缩小,字体、字型皆能任意变化 (每字可以产生数亿种变形) 。而且除了现今各种字典已收的六万余字外,还可以组成完全符合中文规则的新字六百万个,足敷未来新时代新观念的发挥应用。

不仅如此,组字速度又提高了,每秒可以组成 30*30的字形两千个!当然现在用的是15MHZ 80286 ,比以往的4.75 MHZ的Z80 已经快了近六倍。但是,改良后的新程序,其功能的增加,处理过程的繁杂性已远非当年可比。

这些成果,用了很多特殊的数据结构技巧,不可能经由高级语言来完成。既然用汇编语言所制作的程序能一再大幅度地改进,这就说明了汇编语言的弹性极大,效率相去千里。如不痛下苦功钻研,程序写完,能执行就算了事,又怎能领悟其中奥妙?

所以,我并不认为汇编语言只是一种程序语言而已,它是一种创造艺术品的工具,它能赋与无知无觉的电子机器一种「生命」,由无知进而有知,由有知而生智能。通过对汇编语言的研究探索,我整理出一些规律,写成这本书,以便于理解及应用。但是,要真正将汇编语言发展成为艺术,尚有待青年朋友们继续努力,在这个信息时代,开拓出一片崭新的天地。

无意义的音符能编成美妙的音乐,无规律的色彩可幻化为缤纷的世界,为什么计算机的机器指令,不能架构出信息的理性天地?

这就是艺术,作为艺术家,就必须奉献出自己的心血,以真、善、美为最高境界。

要达到这种目的,就要认真的作好准备动作,再一步一步地追求下去。

三、利人与利己

任何一种商业产品,当然是以利益为先,利己后而利人。如果是艺术品创造,则刚刚相反,唯有能忽视己利,沥血泣心地探索,虔诚狂热地奉献,才会迸发出人性的光辉,创造不朽的杰作。

艺术家之伟大,在于此,人性之可贵,在于此。

对组合程序语言,有人视为商品,将写作技巧当作专利,轻不示人。相信这也是迄今尚无一本象样的参考书籍之根本原因,我买了不少这类书,但书中除了指令介绍以及编程、侦错的手续外,完全没有技巧的说明,好象懂得指令就可以把程序写好一般。当我自己下了不少功夫,得到了一些心得,再回过头来看那些参考书,才发现连作者本人所举的例子,都是平铺直叙,毫无技巧可言。

(更正,在序言中我曾提到有本最近出版的"禅-汇编语言",是唯一的例外,希望读者不要错过。)

多年来,我一直想写本有关汇编语言写作技巧的书,可惜都得不到机会。这次,为了实现「整合系统」革命性的计划,所有招收的工程师,一概从头训练。由于没有可用的教材,只好自己动手,于是初步有了讲义,再经修改,便成此书。

我认为,既然汇编语言是种艺术,我们不仅不应该藏私自珍,而且要相互探讨,交流切磋,以期发扬光大。

不过,技术本身与利用该技术所创造的产品却不能混为一谈,产品是借以谋生的工具,能够生存,大家才有研究发展的机会,也才能把成果贡献给社会。如果国人不尊重别人的产品权利,只是互相抄袭盗用,或能受惠于一时,但影响所及,人人贪图现成,不事发展,则观念停顿,技术落伍,其后果不堪设想。

前言

关于本书

本书主要介绍了Vulkan的图形和计算API。Vulkan是Khronos组织(该组织以OpenGL闻名)发布的新一代图形API。这一新的API可以更好地描述应用程序所需的运算,并且相比于OpenGL和Direct3D,拥有更好的性能,更轻便的驱动程序。Vulkan在设计上类似于Direct3D 12和Metal,但比之后两者,Vulkan是跨平台的,可以在Windows,Linux和Android平台上使用。

使用Vulkan不是没有缺点,更精准的控制,意味着更繁琐的细节。我们需要在应用程序中做更多的工作,这包括设置初始时使用的帧缓冲,以及对缓冲和纹理图像的内存管理。

Vulkan并非适合所有人。它是为追求计算机图形性能极限的狂热分子设计的。如果你对游戏开发更感兴趣,或许OpenGL和Direct3D更适合你,它们在短期内仍然会是主流,并且目前还有大量的设备尚未支持Vulkan。除此之外,也可以使用Unreal Engine或Unity这类引擎,它们可以通过封装好的底层完全透明地使用Vulkan。

下面是学习本书的一些先决条件:

-

支持Vulkan的显卡以及驱动程序(NVIDIA,AMD,Intel)

-

C++编程经验(熟悉RAII,初始化列表)

-

支持C++11的编译器(Visual Studio 2013+,GCC 4.8+)

-

三维计算机图形学基础

本书不假设读者了解OpenGL和Direct3D,但需要读者了解基本的三维计算机图形学知识。

读者可以使用C来替换C++,但这样做需要读者对我们的代码进行大量修改。我们的代码使用了类,RAII等C++特性。

电子书

本书有两种格式的电子版提供:

教程结构

我们首先简要介绍Vulkan的工作原理,然后介绍如何使用Vulkan在屏幕上绘制一个三角形。接着,我们介绍如何配置开发环境来使用Vulkan SDK,在这里,我们还引入了GLM库来进行线性代数运算,引入了GLFW库来进行窗口的创建。教程包含了在Windows上使用Visual Studio的配置方法,在Ubuntu上使用GCC的配置方法。

之后,我们将会实现Vulkan绘制三角形的必要部分。每一章节大致遵循下面的结构:

-

介绍新概念,以及它的用途

-

将与之相关的API调用集成到我们的程序中去

-

封装辅助函数

尽管章节的组织有一定顺序,但对于部分章节,完全可以独立阅读,作为一个Vulkan特性的介绍。也就是说,除了作为教程外,本书可以作为Vulkan的一个参考手册,当作字典来查询。书中所有Vulkan函数和类型都被超链接到了Vulkan规范,可以通过鼠标点击,获取它们更加详细的信息。由于Vulkan是一个非常新的API,它的规范文档可能存在许多不足,读者可以提交反馈给Khronos的Github仓库。

之前提到,为了更精准地控制硬件,使用Vulkan需要处理大量细节。这造成许多很基础的操作也需要编写很多代码才能完成。为了简化这类操作的处理,我们会编写一些辅助函数。

每一章节也都包含了总结,以及到此为止的完整代码的超链接。如果读者存在疑惑的地方,可以参考这些代码。这些代码经过了多个不同厂商的显卡测试。

Vulkan是一个非常新的图形API,有关它的最佳实践尚未建立。如果你对本书有任何建议,可以提交反馈到Github仓库。

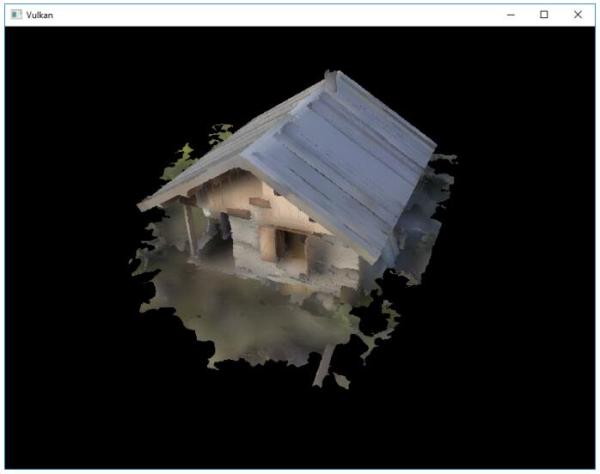

完成使用Vulkan绘制三角形的程序后,我们将对其进行扩展,引入线性变换,纹理和三维模型。

如果读者在之前使用过图形API,应该知道在几何体显示到屏幕之前,需要经过很多步骤。使用Vulkan同样是这样,但这些步骤很容易理解,并且每一步都不多余。绘制三维模型采取的步骤并不比绘制三角形所采取的步骤多很多。

如果在实践本书的过程中遇到问题,读者可以先查看本书的FAQ,是否存在关于这一问题的解决方案,没有的话,欢迎在相关章节进行评论来寻求帮助。

准备好体验高性能次世代图形API了吗?让我们开始吧!

概述

本章节首先简要介绍了Vulkan,以及它所解决的问题。然后,我们将会看到如何使用Vulkan来绘制一个三角形,建立Vulkan的基本使用思路。最后,我们将会介绍Vulkan API的基本结构和使用方式。

Vulkan起源

Vulkan是作为一个跨平台的图形API设计的。以往许多图形API采用固定功能渲染管线设计,应用程序按照一定格式提交顶点数据,配置光照和着色选项。

随着显卡架构逐渐成熟,提供了越来越多的可编程功能,这些功能被集成到原有的API中。造成驱动程序要做的工作越来越复杂,应用程序开发者要处理的兼容性问题也越来越多。随着移动浪潮到来,人们对移动GPU的要求也越来越高,但以往的图形API不能够进行更加精准地控制来提升效率,对多线程的支持也非常不足,导致没有发挥出图形硬件真正的潜力。

由于没有历史包袱,Vulkan完全按照现代图形架构设计,提供了更加详细的API给开发者,大大减少了驱动程序的开销,允许多个线程并行创建和提交指令,使用标准化的着色器字节码,将图形和计算功能进行统一。

画一个三角形

现在,让我们来看下如何使用Vulkan绘制三角形。这里用到的所有概念会在下一章节进行详细地说明。

步骤1:实例和物理设备选择

我们的应用程序是通过VkInstance来使用Vulkan API的。应用程序创建VkInstance后,就可以查询Vulkan支持的硬件,选择其中一个或多个VkPhysicalDevices进行操作。我们可以通过查询设备属性,选择一个适合我们的设备。

步骤2:逻辑设备和队列族

选择完合适的硬件设备后,我们需要使用更详细的VkPhysicalDevice特性(比如多视口,64位浮点)来创建一个逻辑设备VkDevice。还需要指定我们想要使用的队列族。Vulkan将诸如绘制指令、内存操作提交到VkQueue中,进行异步执行。队列由队列族分配,每个队列族支持一个特定操作集合。比如,图形,计算和内存传输操作可以使用独立的队列族。队列族可以作为物理设备选择时的一个参考。比如,一个支持Vulkan的设备可能没有提供任何图形功能,但对于支持Vulkan的显卡设备而言,支持所有队列操作。

步骤3:窗口表面和交换链

如果不是进行离屏渲染,通常我们需要创建一个窗口来显示渲染的图像。这一工作可以通过原生平台的窗口API或像GLFW或SDL这样的库来完成,在这里,我们使用的是GLFW,有关GLFW的更多信息,我们会在下一章介绍。

我们还需要两个组件才能完成窗口渲染:窗口表面(VkSurfaceKHR)和交换链(VkSwapChainKHR)。可以注意到这两个组件都有一个KHR后缀,这表示它们属于Vulkan扩展。Vulkan API本身是完全平台无关的,需要我们使用WSI(Window System Interface,窗口系统接口)扩展与原生的窗口管理器进行交互。表面(Surface)是一个跨平台抽象,通常它是由原生窗口系统句柄作为参数实例化得到。不过,这一部分工作,GLFW已经帮我们处理了,所以不用我们关心。

交换链是一个渲染目标集合。它可以保证我们正在渲染的图像和当前屏幕图像是两个不同的图像。这可以确保显示出来的图像是完整的。每次绘制一帧时,可以请求交换链提供一张图像。绘制完成后,图像被返回到交换链中,在之后某个时刻,图像被显示到屏幕上。渲染目标数量和图像显示到屏幕的时机依赖于显示模式。常用的显示模式有双缓冲(vsync,垂直同步)和三缓冲。我们将在创建交换链章节讨论这些问题。

步骤4:图像视图和帧缓冲

从交换链获取图像后,还不能直接在图像上进行绘制,需要将图像先包装进VkImageView和VkFramebuffer中去。一个图像视图可以引用图像的特定部分,一个帧缓冲可以引用图像视图作为颜色,深度和模板目标。交换链中可能有多个不同的图像,我们可以预先为它们每一个都创建好图像视图和帧缓冲,然后在绘制时选择对应的那个。

步骤5:渲染流程

渲染流程描述了渲染操作使用的图像类型,图像的使用方式,图像的内容如何处理。对于我们这个绘制三角形的程序,我们使用了一张图像作为颜色目标,在执行绘制操作前清除整个图像。渲染流程只描述了图像的类型,图像绑定是通过VkFramebuffer完成的。

步骤6:图形管线

Vulkan的图形管线可以通过VkPipeline对象建立。它描述了显卡的可配置状态,比如视口大小和深度缓冲操作,以及使用VkShaderModule对象的可编程状态。VkShaderModule对象由着色器字节码创建而来。驱动程序知道哪些渲染目标被图形管线使用。

Vulkan与之前的图形API的一个最大不同是几乎所有图形管线的配置都需要提前完成。这意味着如果我们想要使用另外一个着色器或者顶点布局,需要重新创建整个图形管线。显然效率很低,这迫使我们提前创建出所有我们需要的图形管线,在需要时直接使用已经创建好的图形管线。图形管线只有很少一部分配置可以动态修改,比如视口大小和清除颜色。图形管线的所有状态也需要显式地描述,比如,不存在默认的颜色混合状态。

这样做的好处类似于预编译相比于即时编译,驱动程序可以有更大的优化空间,并且以图形管线为切换单位,渲染效果的预期也变得十分容易,不用担心切换时,遗漏某个微小的设置,造成结果的巨大差异。

步骤7:指令池和指令缓冲

之前提到,Vulkan的许多操作需要提交到队列才能执行。这些操作首先被记录到一个VkCommandBuffer对象中,然后提交给队列。VkCommandBuffer对象由一个关联了特定队列族的VkCommandPool分配而来。为了绘制三角形,我们需要记录下列操作到VkCommandBuffer对象中去:

-

开始渲染

-

绑定图形管线

-

绘制三角形

-

结束渲染

由于帧缓冲绑定的图像依赖于交换链给我们的图像,我们可以提前为每个图像建立指令缓冲,然后在绘制时,直接选择对应的指令缓冲使用。当然在每一帧记录指令缓冲也是可以的,但这样做效率很低。

步骤8:主循环

将绘制指令包装进指令缓冲后,主循环变得非常直白。我们首先使用vkAcquireNextImageKHR函数从交换链获取一张图像。接着使用vkQueueSubmit函数提交图像对应的指令缓冲。最后,使用vkQueuePresentKHR函数将图像返回给交换链,显示图像到屏幕。

提交给队列的操作会被异步执行。我们需要采取同步措施比如信号量来确保操作按正确的顺序执行。绘制指令的执行必须在获取图像之后,否则,可能会出现读写冲突,屏幕正在读取图像数据的同时,绘制操作在进行绘制操作,造成屏幕读取显示的数据并非来自同一帧。同样,vkQueuePresentKHR函数调用需要在绘制完成后进行。

总结

本章节通过绘制一个简单的三角形来使读者建立Vulkan的基本使用思路。通常,一个真正实用的程序会包含更多的步骤,比如分配顶点缓冲,创建Uniform缓冲,上传纹理图像等等。但为了降低学习难度,我们从最简单的形式开始,逐步复杂化。

对于绘制一个三角形,我们需要采取的步骤包括:

-

创建一个VkInstance

-

选择一个支持Vulkan的图形设备(VkPhysicalDevice)

-

为绘制和显示操作创建VkDevice和VkQueue

-

创建一个窗口,窗口表面和交换链

-

将交换链图像包装进VkImageView

-

创建一个渲染层指定渲染目标和使用方式

-

为渲染层创建帧缓冲

-

配置图形管线

-

为每一个交换链图像分配指令缓冲

-

从交换链获取图像进行绘制操作,提交图像对应的指令缓冲,返回图像到交换链

看起来步骤非常多,但其实每一步都非常简单。在接下来的章节,我们会对每一步进行非常详细地说明。如果你对程序中的某一步感到困惑,可以回来参考一下本章节。

API概念

本小节对Vulkan API的结构进行简要的介绍。

编码约定

Vulkan的所有函数、枚举和结构体都被定义在vulkan.h中,我们可以在Vulkan SDK中找到这一头文件。在下一章节,我们会介绍如何安装Vulkan SDK。

Vulkan API的函数都带有一个小写的vk前缀,枚举和结构体名带有一个Vk前缀,枚举值带有一个VK_前缀。Vulkan对结构体非常依赖,大量函数的参数由结构体提供。比如,Vulkan创建对象的一般形式如下:

VkXXXCreateInfo createInfo = {};

createInfo.sType = VK_STRUCTURE_TYPE_XXX_CREATE_INFO;

createInfo.pNext = nullptr;

createInfo.foo = ...;

createInfo.bar = ...;

VkXXX object;

if (vkCreateXXX(&createInfo, nullptr, &object) != VK_SUCCESS) {

std::cerr << "failed to create object" << std::endl;

return false;

}

Vulkan的许多结构体需要我们通过设置sType成员变量来显式指定结构体类型。结构体的pNext成员可以指向一个扩展的结构体,在本教程,我们不使用它,它被设置为nullptr。Vulkan中创建和销毁对象的函数都有一个VkAllocationCallbacks参数,可以被用来自定义内存分配器,在这里,我们不使用它,将其设置为nullptr。

几乎所有Vulkan都会返回一个VkResult来表示调用的执行情况,它的值要么是VK_SUCCESS,要么是一个错误代码。Vulkan规范文档描述了这些函数返回的错误代码的意义。

校验层

之前提到,Vulkan的设计目标是高性能、低驱动程序开销。所以,默认情况下,它提供的错误检测和调试功能非常有限。驱动程序会在发生错误时直接崩溃,而不是返回一个错误代码。这可能导致对于某种显卡可以工作,不会崩溃,但对于其它显卡无法工作,驱动程序崩溃。

可以通过Vulkan的校验层(Validation layers)特性来进行一定的错误检查措施。校验层是一段被插入在Vulkan API和驱动程序之间的代码,可以对Vulkan API函数的参数进行检查,跟踪内存分配。我们可以在开发期开启校验层,然后在发布程序时关闭校验层,减少性能损失。校验层可以完全自己编写,但为了方便,我们的教程直接使用了Vulkan SDK提供的一组校验层。我们通过注册的回调函数来接受来自校验层的调试信息。

由于Vulkan的每个操作都要显式定义,加之校验层的使用,调试使用Vulkan的程序要比调试使用OpenGL和Direct3D的程序轻松太多。

接下来让我们配置开发环境,开始我们的Vulkan编程之旅吧!

开发环境

在本章节,我们将介绍如何配置Vulkan SDK和一些非常有用的库。所有在这里用到的工具除了编译器外,适用于Windows,Linux和MacOS三个平台,但它们的安装方法可能在不同平台会有所不同,所以在这里我们按平台分别描述如何配置它们。

Windows

我们这里使用Visual Studio 2017作为Windows平台的开发环境,当然使用Visual Studio 2013或2015应该也不会有任何问题,只是配置方法可能会略微不同。

Vulkan SDK

Vulkan SDK是使用Vulkan开发应用程序必不可少的组件。它包含了Vulkan API的头文件,一个校验层实现,调试工具和Vulkan函数加载器。Vulkan函数加载器类似OpenGL的GLEW可以在运行时查询驱动程序支持的Vulkan API函数。

Vulkan SDK可以从LunarG的网站上免费下载。

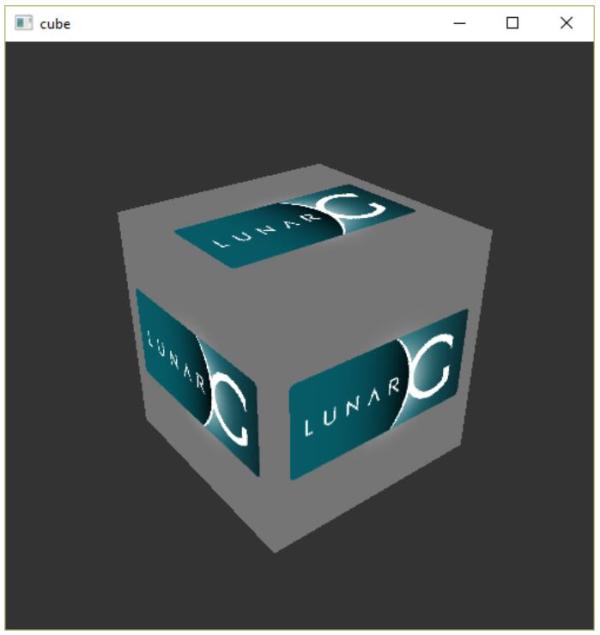

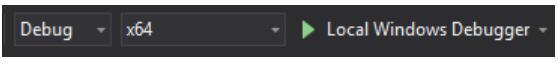

安装Vulkan SDK后,我们需要验证下我们的显卡和驱动程序是否支持Vulkan。这可以通过运行Vulkan SDK自带的cube.exe来完成,我们可以在Vulkan SDK安装目录下的Bin目录下找到它,运行后,可以看下到下面的窗口:

如果没有看到这个窗口,而是出现了一条错误消息,可以尝试更新显卡的驱动程序到最新版本,再次尝试,如果仍然出现错误消息,可以在显卡官网查询自己的显卡是否支持Vukan。

在Bin目录下还有一个非常有用的程序:glslangValidator.exe。它可以将GLSL代码编译为字节码。我们会在着色器模块章节,对它进行更为详细地说明。除此之外,Bin目录下还包含了Vulkan函数加载器和校验层的二进制文件,它们的库文件则位于Vulkan SDK的Lib目录下。

Vulkan SDK的Documentation目录包含了Vulkan SDK的离线文档和完整的Vulkan规范文档。最后是Vulkan SDK的Include目录,它包含了Vulkan API的头文件。除此之外,还有很多文件和目录,但对于我们的教程来说,并没有直接用到它们,所以就不再一一介绍。

GLFW

之前提到,Vulkan是一个平台无关的图形API,它没有包含任何用于创建窗口的功能。为了跨平台和避免陷入Win32的窗口细节中去,我们使用GLFW库来完成窗口相关操作,GLFW库支持Windows,Linux和MacOS。当然,还有其它一些库可以完成类似功能,比如SDL。但除了窗口相关处理,GLFW库对于Vulkan的使用还有其它一些优点。

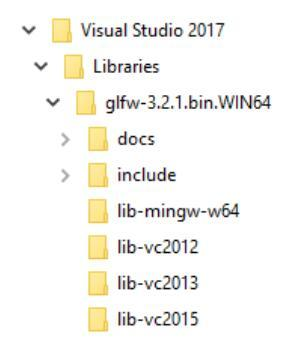

读者可以再GLFW的官方网站上免费下载到最新版本的GLFW库。在本教程,我们使用64位版本的GLFW库,但32位版本也是可以的,只是编译使用Vulkan的应用程序时也需要链接到32位版本的Vulkan API,也就是链接到Vulkan SDK下Lib32目录下的库。下载GLFW后,将它解压缩到一个合适的位置。这里,我们将它解压到Visual Studio目录下的Libraries目录中。不要纠结于为什么解压后不存在libvc-2017目录,我们的Visual Studio 2017是完全兼容lib-vc2015的。

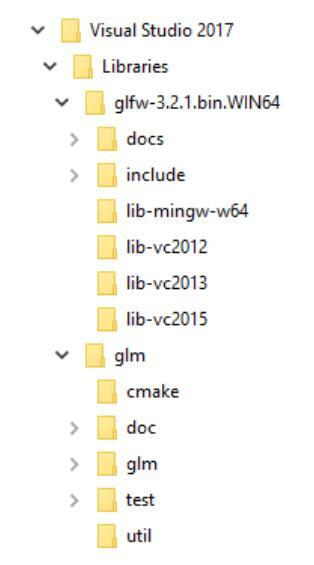

GLM

和DirectX 12不同,Vulkan没有包含线性代数库,我们需要自己找一个。GLM就是一个我们需要的线性代数库,它经常和OpenGL一块使用。

GLM是一个只有头文件的库,我们只需要下载它的最新版,然后将它放在一个合适的位置,就可以通过包含头文件的方式使用它。

配置Visual Studio

现在,我们可以创建一个基本Visual Studio工程来验证我们安装的依赖是否可以正常工作。

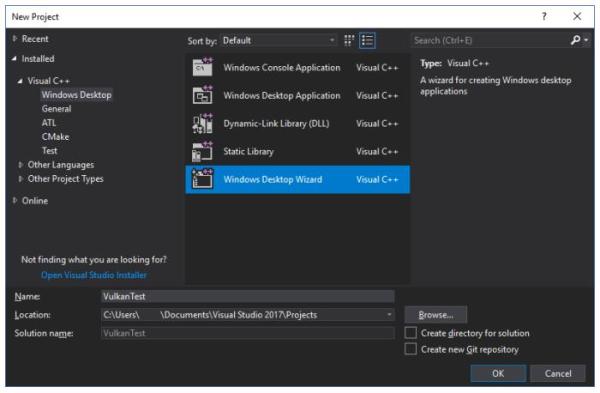

首先,启动Visual Studio,然后选择Windows Destop Wizard。

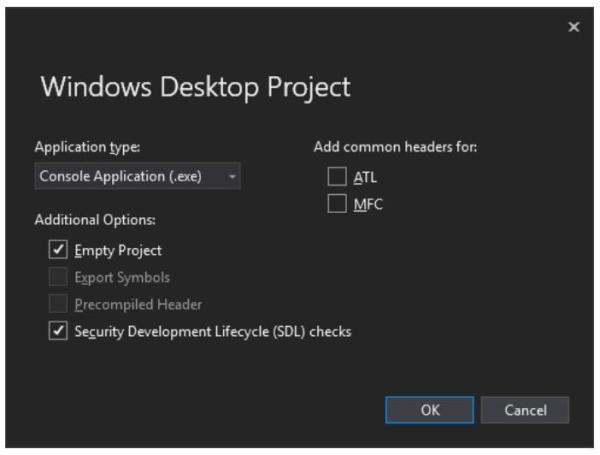

我们选择使用Console Application (.exe)应用程序类型,这样做我们就可以直接将调试信息输出到控制台窗口上。另外,我们将Empty Project选项打勾来阻止Visual Studo添加模板代码。

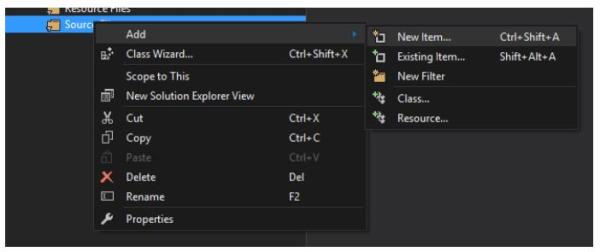

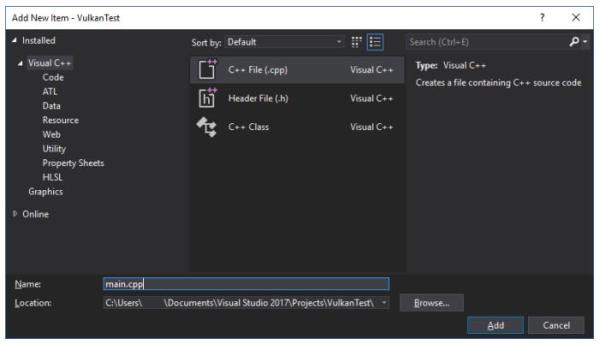

创建项目后,我们添加一个C++源代码文件到项目中。

下面的代码是这个C++源文件的内容。源代码的内容暂时不需要理解,我们现在只是为了验证我们的依赖是否配置正确,源代码的内容,我们会在后面的章节详细说明。

#define GLFW_INCLUDE_VULKAN

#include <GLFW/glfw3.h>

#define GLM_FORCE_RADIANS

#define GLM_FORCE_DEPTH_ZERO_TO_ONE

#include <glm/vec4.hpp>

#include <glm/mat4x4.hpp>

#include <iostream>

int main() {

glfwInit();

glfwWindowHint(GLFW_CLIENT_API, GLFW_NO_API);

GLFWwindow* window = glfwCreateWindow(800, 600, "Vulkan window", nullptr, nullptr);

uint32_t extensionCount = 0;

vkEnumerateInstanceExtensionProperties(nullptr,

&extensionCount, nullptr);

std::cout << extensionCount << " extensions supported" << std::endl;

glm::mat4 matrix;

glm::vec4 vec;

auto test = matrix * vec;

while(!glfwWindowShouldClose(window)) {

glfwPollEvents();

}

glfwDestroyWindow(window);

glfwTerminate();

return 0;

}

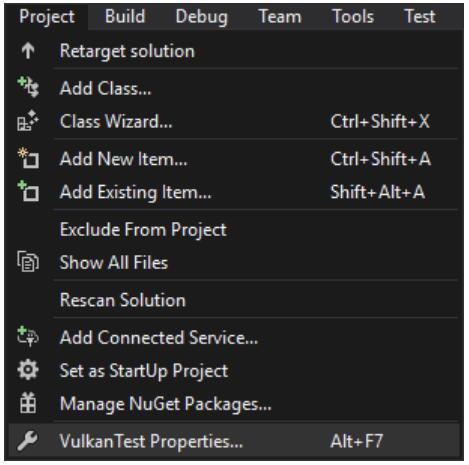

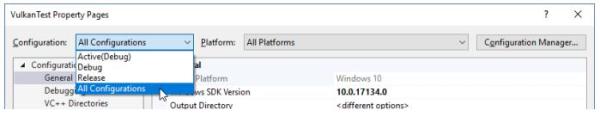

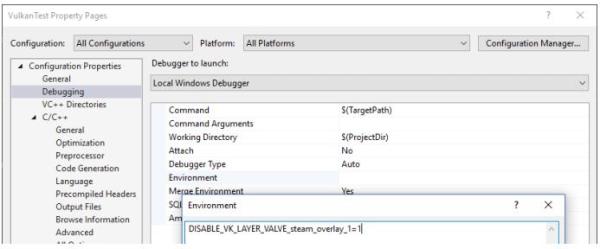

现在,让我们开始配置项目属性,选择All Configurations,让设置对Debug和Release模式都有效。

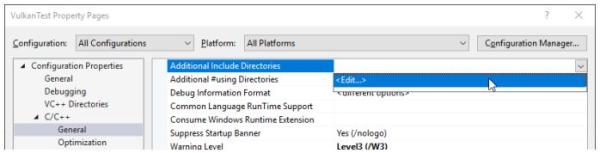

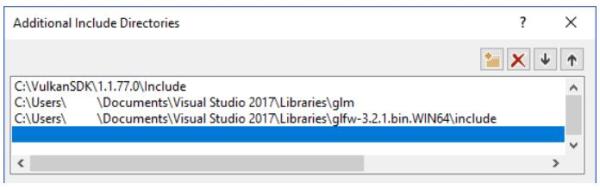

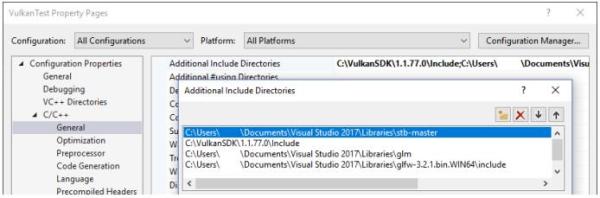

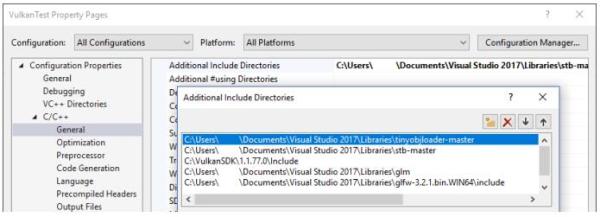

打开C++ -> General -> Additional Include Directories,点击Additional Include Directories的<Edit...>下拉选项。

添加Vulkan,GLFW和GLM的头文件目录:

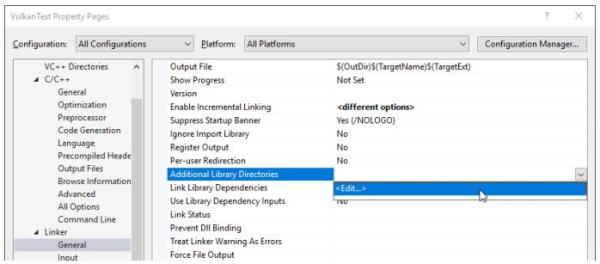

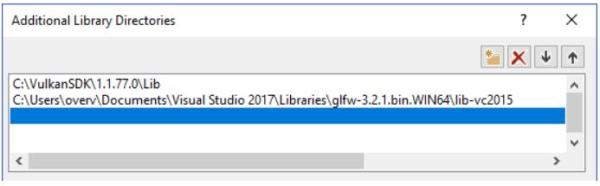

接着,打开Linker -> General:

添加Vulkan和GLFW的库目录:

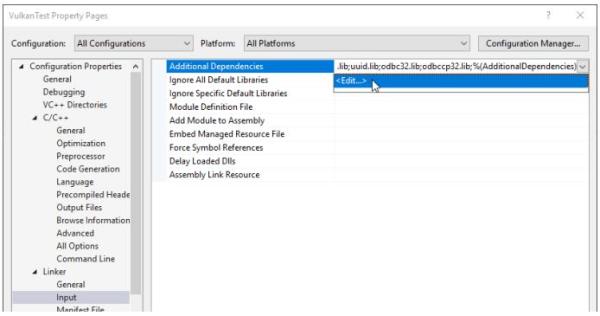

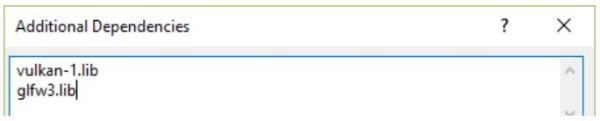

打开 Linker -> Input,点击Additional Dependencies的<Edit...>下拉选项:

添加Vulkan和GLFW的库文件:

现在可以关闭项目属性对话框了。如果一切顺利,我们的代码编辑器里已经没有任何高亮出的错误代码了。

最后,确认我们的代码在64位模式下编译:

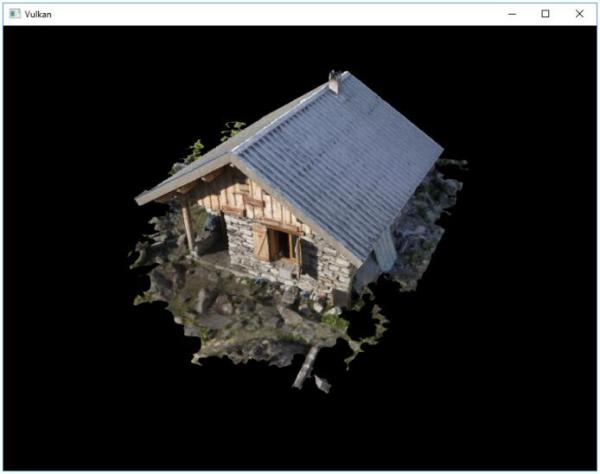

然后,按下F5编译运行,你就会看到下面的窗口:

控制台窗口显示的扩展数应该是非0的。至此,我们就配置好了Vulkan的开发环境!

Linux

对于Linux平台的配置,我们使用Ubuntu作为演示,其它Linux平台的配置方法应该是类似的。我们使用二进制包来安装Vulkan SDK,使用GCC 4.8以上版本作为编译器,使用CMake和make作为构建系统。

Vulkan SDK

Vulkan SDK是使用Vulkan开发应用程序必不可少的组件。它包含了Vulkan API的头文件,一个校验层实现,调试工具和Vulkan函数加载器。Vulkan函数加载器类似OpenGL的GLEW可以在运行时查询驱动程序支持的Vulkan API函数。

Vulkan SDK可以从LunarG的网站上免费下载。

打开终端,调整当前目录到我们下载的Vulkan SDK安装文件所在目录,然后使用下面的代码运行它:

chmod +x vulkansdk-linux-x86_64-xxx.run

./vulkansdk-linux-x86_64-xxx.run

安装文件运行后会将Vulkan SDK的所有文件导出到当前目录的VulkanSDK文件夹中。我们可以自己将VulkanSDK文件夹移动到合适的位置。

Vulkan SDK的根目录有一个build_examples.sh脚本,执行它构建Vulkan SDK的示例程序需要我们安装XCB库,以及一些X窗口的开发文件,可以通过在终端运行下面的代码来安装这些所需的库:

sudo apt install libxcb1-dev xorg-dev

然后,我们就可以执行build_examples.sh了:

./build_examples.sh

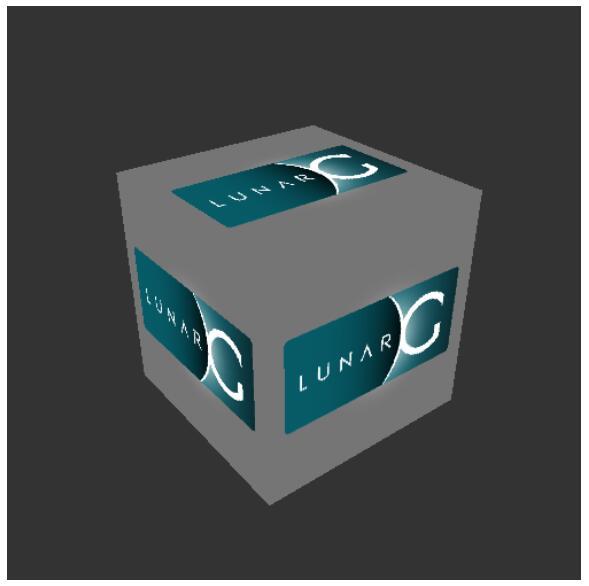

如果编译成功,在./examples/build/下就会出现一个cube可执行文件,运行它,可以看到下面的画面:

如果没有看到,而是出现了一条错误消息,可以尝试更新显卡的驱动程序到最新版本,再次尝试,如果仍然出现错误消息,可以在显卡官网查询自己的显卡是否支持Vukan。

GLFW

之前提到,Vulkan是一个平台无关的图形API,它没有包含任何用于创建窗口的功能。为了跨平台和避免陷入X11的窗口细节中去,我们使用GLFW库来完成窗口相关操作,GLFW库支持Windows,Linux和MacOS。当然,还有其它一些库可以完成类似功能,比如SDL。但除了窗口相关处理,GLFW库对于Vulkan的使用还有其它一些优点。

这里,由于Vulkan需要较新版本的GLFW才能支持。所以,我们使用源代码来编译安装GLFW。读者可以从GLFW的官方网站免费下载到GLFW的最新源码包。下载完成后,我们将源码包解压,使用终端进入解压的源码所在的文件夹,执行下面的代码生成makefile文件,然后编译GLFW:

cmake .

make

可能会出现Could NOT find Vulkan的警告信息,可以放心地忽略掉它。编译完成后,使用下面的代码将GLFW安装到系统的库目录中:

sudo make install

GLM

和DirectX 12不同,Vulkan没有包含线性代数库,我们需要自己找一个。GLM就是一个我们需要的线性代数库,它经常和OpenGL一块使用。

GLM是一个只有头文件的库,我们只需要下载它的最新版,然后将它放在一个合适的位置,就可以通过包含头文件的方式使用它。

这里我们直接在终端使用下面的代码安装它:

sudo apt install libglm-dev

配置makefile文件

现在,我们已经安装完了所有的依赖项,可以开始配置应用程序的makefile,验证安装是否正确。

在一个合适的位置新建一个叫做VulkanTest的文件夹,然后在文件夹里创建包含下面代码的main.cpp源代码文件。

#define GLFW_INCLUDE_VULKAN

#include <GLFW/glfw3.h>

#define GLM_FORCE_RADIANS

#define GLM_FORCE_DEPTH_ZERO_TO_ONE

#include <glm/vec4.hpp>

#include <glm/mat4x4.hpp>

#include <iostream>

int main() {

glfwInit();

glfwWindowHint(GLFW_CLIENT_API, GLFW_NO_API);

GLFWwindow* window = glfwCreateWindow(800, 600, "Vulkan

window", nullptr, nullptr);

uint32_t extensionCount = 0;

vkEnumerateInstanceExtensionProperties(nullptr,

&extensionCount, nullptr);

std::cout << extensionCount << " extensions supported" << std::endl;

glm::mat4 matrix;

glm::vec4 vec;

auto test = matrix * vec;

while(!glfwWindowShouldClose(window)) {

glfwPollEvents();

}

glfwDestroyWindow(window);

glfwTerminate();

return 0;

}

源代码的内容暂时不需要理解,我们现在只是为了验证我们的依赖是否配置正确,源代码的内容,我们会在后面的章节详细说明。

接着,我们需要编写makefile来编译源代码。这里假设读者具有一定makefile使用经验,知道makefile的变量和规则的用法。如果没有,也可以从本教程中快速学习这些知识。

我们首先定义一些变量来简化makefile编写。VULKAN_SDKPATH变量存放了Vulkan SDK的x86_64目录的位置:

VULKAN_SDK_PATH = /home/user/VulkanSDK/x.x.x.x/x86_64

读者应该替换上面代码的路径为自己Vulkan SDK的实际路径。接着,我们定义CFLAGS变量来指定编译选项:

CFLAGS = -std=c++11 -I$(VULKAN_SDK_PATH)/include

上面的代码表示使用C++ 11来编译源代码,将Vulkan SDK的包含目录加入编译器的包含目录搜索路径中。

然后,定义LDFLAGS变量来指定链接选项:

LDFLAGS = -L$(VULKAN_SDK_PATH)/lib `pkg-config --static --libs glfw3` -lvulkan

上面的代码将Vulkan SDK的库路径加入链接器的库搜索路径中,链接了Vulkan SDK的vulkan库,使用pkg-config命令取得了glfw静态链接选项。 现在可以开始定义编译VulkanTest的规则了:

VulkanTest: main.cpp

g++ $(CFLAGS) -o VulkanTest main.cpp $(LDFLAGS)

验证规则是否正确,可以将上面的代码保存为Makefile文件,然后使用终端在Makefile文件所在目录执行make命令。如果一切顺利,会生成一个VulkanTest可执行文件。

现在,我们定义另外两个规则,test和clean,前一个规则用于执行生成的可执行文件,后一个规则用于清除生成的可执行文件:

.PHONY: test clean

test: VulkanTest

./VulkanTest

clean:

rm -f VulkanTest

验证规则能否执行后,读者可能会发现make clean工作的非常好,但make test却产生了下面的错误信息:

./VulkanTest: error while loading shared libraries:

libvulkan.so.1: cannot open shared object file: No such file or directory

这是因为libvulkan.so没有被安装在系统的库目录,无法被VulkanTest加载。我们可以通过LD_LIBRARY_PATH环境变量显式指定库目录来解决这个问题:

test: VulkanTest

LD_LIBRARY_PATH=$(VULKAN_SDK_PATH)/lib ./VulkanTest

现在make test应该可以成功执行VulkanTest了。

test: VulkanTest

LD_LIBRARY_PATH=$(VULKAN_SDK_PATH)/lib\

VK_LAYER_PATH=$(VULKAN_SDK_PATH)/etc/explicit_layer.d\

./VulkanTest

至此,我们的Makefile文件已经编写完毕了,它的所有内容如下:

VULKAN_SDK_PATH = /home/user/VulkanSDK/x.x.x.x/x86_64

CFLAGS = -std=c++11 -I$(VULKAN_SDK_PATH)/include

LDFLAGS = -L$(VULKAN_SDK_PATH)/lib `pkg-config --static --libs glfw3` -lvulkan

VulkanTest: main.cpp

g++ $(CFLAGS) -o VulkanTest main.cpp $(LDFLAGS)

.PHONY: test clean

test: VulkanTest

LD_LIBRARY_PATH=$(VULKAN_SDK_PATH)/lib\

VK_LAYER_PATH=$(VULKAN_SDK_PATH)/etc/ex plicit_layer.d\

./VulkanTest

clean:

rm -f VulkanTest

读者可以将刚刚配置的Makefile文件作为一个模板在以后使用。

现在,让我们花点实践浏览下Vulkan SDK目录,在x86_64/bin目录下还有一个非常有用的程序:glslangValidator。它可以将GLSL代码编译为字节码。我们会在着色器模块章节,对它进行更为详细地说明。除此之外,Bin目录下还包含了Vulkan函数加载器和校验层的二进制文件,它们的库文件则位于Vulkan SDK的Lib目录下。

Vulkan SDK的Doc目录包含了Vulkan SDK的离线文档和完整的Vulkan规范文档。最后是Vulkan SDK的Include目录,它包含了Vulkan API的头文件。除此之外,还有很多文件和目录,但对于我们的教程来说,并没有直接用到它们,所以就不再一一介绍。

至此,我们已经做好开始Vulkan探险之旅的准备!

MacOS

这里假定读者使用Xcode和Homebrew包管理器。另外还需要我们的MacOS版本在10.11以上,显卡设备支持Metal API。

Vulkan SDK

Vulkan SDK是使用Vulkan开发应用程序必不可少的组件。它包含了Vulkan API的头文件,一个校验层实现,调试工具和Vulkan函数加载器。Vulkan函数加载器类似OpenGL的GLEW可以在运行时查询驱动程序支持的Vulkan API函数。

Vulkan SDK可以从LunarG的网站上免费下载。

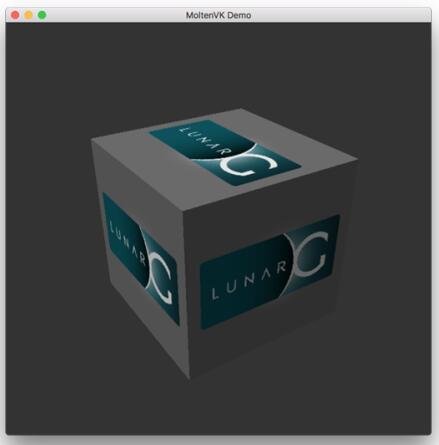

Vulkan SDK的MacOS版本是通过MoltenVK实现的,并非原生实现,也就是说MoltenVK作为一个中间层将Vulkan API调用转换为Metal调用。这也使得我们可以直接使用Metal的调试功能进行调试。

下载Vulkan SDK后,将它解压到一个合适的位置,在解压后的目录中的Applications,可以找到一些Vulkan SDK的演示程序,运行其中的可执行文件cube,你将会看到下面的窗口:

GLFW

之前提到,Vulkan是一个平台无关的图形API,它没有包含任何用于创建窗口的功能。为了跨平台和避免陷入窗口操作相关的细节中去,我们使用GLFW库来完成窗口相关操作,GLFW库支持Windows,Linux和MacOS。当然,还有其它一些库可以完成类似功能,比如SDL。但除了窗口相关处理,GLFW库对于Vulkan的使用还有其它一些优点。

我们使用Homebrew包管理器来安装GLFW库。GLFW的3.2.1稳定版目前还尚未完全支持Vulkan,所以我们使用下面的代码安装glfw3包的最新版本:

brew install glfw3 --HEAD

GLM

Vulkan没有包含线性代数库,我们需要自己找一个。GLM就是一个我们需要的线性代数库,它经常和OpenGL一块使用。

GLM是一个只有头文件的库,我们只需要下载它的最新版,然后将它放在一个合适的位置,就可以通过包含头文件的方式使用它。

这里我们直接在终端使用下面的代码安装它:

brew install glm

配置Xcode

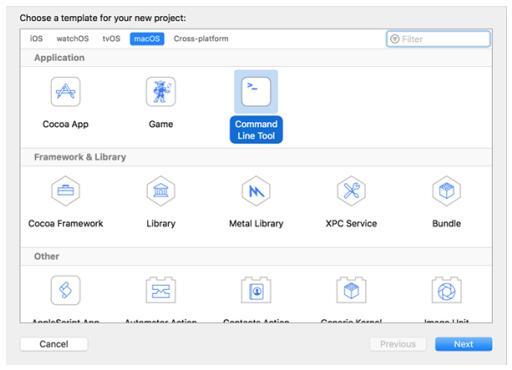

现在所有的依赖项已经安装完毕,我们可以开始配置一个最基本的用于Xcode的Vulkan项目。

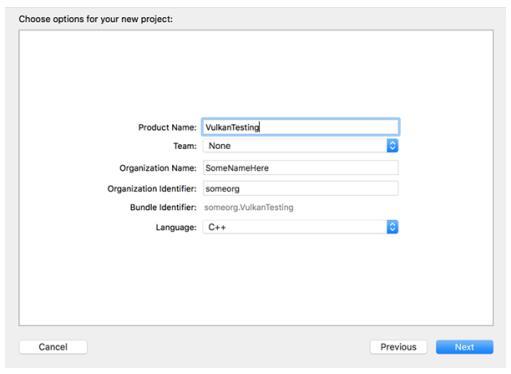

启动Xcode,然后新建一个Xcode项目,选择Application > Command Line Tool项目类型:

接着,选择C++作为项目使用的语言:

现在将下面的代码作为项目的main.cpp源文件的内容:

#define GLFW_INCLUDE_VULKAN

#include <GLFW/glfw3.h>

#define GLM_FORCE_RADIANS

#define GLM_FORCE_DEPTH_ZERO_TO_ONE

#include <glm/vec4.hpp>

#include <glm/mat4x4.hpp>

#include <iostream>

int main() {

glfwInit();

glfwWindowHint(GLFW_CLIENT_API, GLFW_NO_API);

GLFWwindow* window = glfwCreateWindow(800, 600, "Vulkan

window", nullptr, nullptr);

uint32_t extensionCount = 0;

vkEnumerateInstanceExtensionProperties(nullptr,

&extensionCount, nullptr);

std::cout << extensionCount << " extensions supported" << std::endl;

glm::mat4 matrix;

glm::vec4 vec;

auto test = matrix * vec;

while(!glfwWindowShouldClose(window)) {

glfwPollEvents();

}

glfwDestroyWindow(window);

glfwTerminate();

return 0;

}

源代码的内容暂时不需要理解,我们现在只是为了验证我们的依赖是否配置正确,源代码的内容,我们会在后面的章节详细说明。

现在Xcode应该会显示一些诸如库未找到的错误。我们接下来的工作就是解决这些错误。在Project Navigator面板选择我们的项目,然后打开Build Settings标签页,进行下面的操作:

-

将/usr/local/include加入Header Search Paths,这是Homebrew安装头文件的路径,我们安装的glm和glfw3的头文件都在该文件夹下,然后将vulkansdk/macOS/include加入Header Search Paths,vulkansdk为我们安装的Vulkan SDK的目录。这样Xcode就可以找到我们使用的库的头文件。

-

将/usr/local/lib加入Library Search Paths,这是Homebrew安装库文件的路径,我们安装的glm和glfw3的库文件都在该文件夹下,然后将vulkansdk/macOS/lib加入Library Search Paths,vulkansdk为我们安装的Vulkan SDK的目录。这样Xcode就可以找到我们使用的库文件。

设置完成后,看起来像这样(实际内容依赖于我们自己的文件所在的位置):

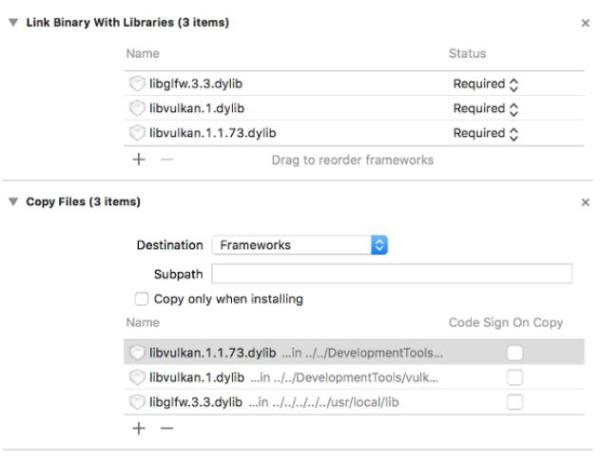

现在,点击 Build Phases标签页,添加glfw3和vulkan框架。这里,为了简便,我们添加的是动态库(如果想要使用静态库,可以参考这些库的官方文档)。

-

对于glfw,打开/usr/local/lib目录,可以找到类似libglfw.3.x.dylib形式的文件(x是库的版本号,依赖于我们使用Homebrew下载安装的glfw的版本)。将这个文件拖拽到Linked Frameworks and Libraries标签页即可。

-

对于Vulkan,打开vulkansdk/macOS/lib目录(vulkansdk是我们的Vulkan SDK所在目录),拖拽libvulkan.1.dylib和libvulkan.1.x.xx.dylib文件到Linked Frameworks and Libraries标签页即可。

完成上面的操作后,更改Copy Files标签页下的Destination为Frameworks,然后清空Subpath文本框,去掉勾选Copy only when installing,点击+号,将所有三个动态库添加进去。

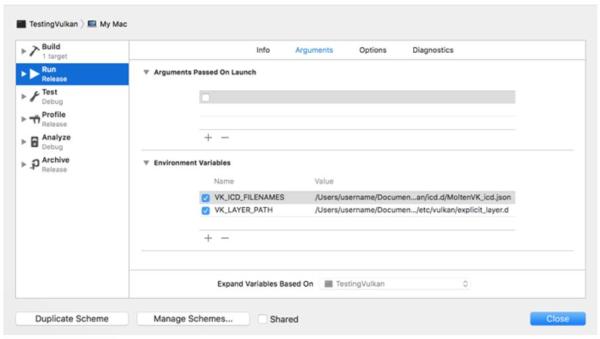

最后,我们需要配置环境变量。在Xcode的工具栏上通过Product > Scheme > Edit Scheme...打开Arguments标签页,添加下面的环境变量:

-

VK_ICD_FILENAMES = vulkansdk/macOS/etc/vulkan/icd.d/MoltenVK_icd.json

-

VK_LAYER_PATH = vulkansdk/macOS/etc/vulkan/explicit_layer.d

完成后,看起来像这样:

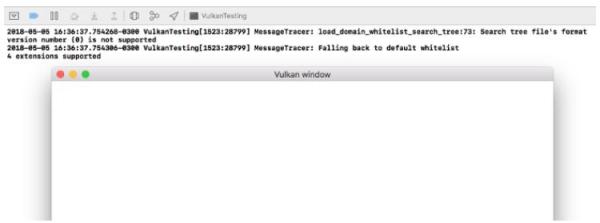

至此为止,我们完成了全部设置,可以编译运行项目了,效果如下:

程序输出的日志信息中的扩展数应该是非0的 。 现在,我们已经做好开始Vulkan探险之旅的准备!

基础代码

一般结构

在本章节,我们开始使用Vulkan API编写代码。

#include <vulkan/vulkan.h>

#include <iostream>

#include <stdexcept>

#include <functional>

#include <cstdlib>

class HelloTriangleApplication {

public:

void run() {

initVulkan();

mainLoop();

cleanup();

}

private:

void initVulkan() {

}

void mainLoop() {

}

void cleanup() {

}

};

int main() {

HelloTriangleApplication app;

try {

app.run();

} catch (const std::exception& e) {

std::cerr << e.what() << std::endl;

return EXIT_FAILURE;

}

return EXIT_SUCCESS;

}

代码中,我们首先包含了Vulkan API的头文件,它为我们提供了Vulkan API的函数,结构体和枚举。此外,包含stdexcept和iostream头文件用来报错。包含functional头文件用于资源管理。包含cstdlib头文件用来使用EXITSUCCESS和EXIT_FAILURE宏。

我们将程序本身包装为一个类,将Vulkan对象存储为类的私有成员。我们使用initVulkan函数来初始化Vulkan对象。初始化完成后,我们进入主循环进行渲染操作。mainLoop函数包含了一个循环,直到窗口被关闭,才会跳出这个循环。mainLoop函数返回后,我们使用cleanup函数完成资源的清理。

程序在执行过程中,如果发生错误,会抛出一个带有错误描述信息的std::runtime_error异常,我们在main函数捕获这个异常,并将异常的描述信息打印到控制台窗口。为了处理多种不同类型的异常,我们使用更加通用的std::exception来接受异常。一个比较常见的异常就是请求的扩展不被支持。

接下来的每一章,我们会添加新的成员到我们的类中,然后在initVulkan函数中初始化它们,在cleanup函数中清理它们。

资源管理

和使用malloc函数分配的内存块相同,使用Vulkan API创建的Vulkan对象也需要在不需要它们时显式地被清除。现代C++可以通过<memory>头文件自动地进行资源管理,但在这里,为了让大家更加清晰地理解Vulkan对象地创建和清除,以及它们的生命周期,我们没有使用它,而是手动自己完成资源管理。除此之外,Vulkan的一个核心思想就是通过显式地定义每一个操作来避免出现不一致的现象。

学完本教程后,读者可以通过重载std::shared_ptr来实现自动资源管理。将RAII应用到自己的程序中。但对于学习而言,最好是能清晰地理解每一个细节部分。

Vulkan对象可以直接通过类似vkCreateXXX的函数,或是通过其它对象调用类似vkAllocateXXX的函数创建。当创建的对象不再使用时,使用对应的vkDestroyXXX或vkFreeXXX函数进行清除操作。这些函数的参数对于不同类型的对象通常是不同的,但都具有一个pAllocator参数。我们可以通过这个参数来指定回调函数编写自己的内存分配器。但在本教程,我们没有使用它,将它设置为nullptr。

和GLFW交互

Vulkan可以在完全没有窗口的情况下工作,通常,在离屏渲染时会这样做。但一般而言,还是需要一个窗口来显示渲染结果给用户。接下来,我们要完成的就是窗口相关操作。

首先替换代码中的#include <vulkan/vulkan.h>为:

#define GLFW_INCLUDE_VULKAN

#include <GLFW/glfw3.h>

上面的代码将GLFW库的定义包含进来,而GLFW库会自动包含Vulkan库的头文件。接着,我们添加一个叫做initWindow的函数来初始化GLFW,并在run函数中调用它:

void run() {

initWindow();

initVulkan();

mainLoop();

cleanup();

}

private:

void initWindow() {

}

initWIndow函数首先调用了glfwInit函数来初始化GLFW库,由于GLFW库最初是为OpenGL设计的,所以我们需要显式地设置GLFW阻止它自动创建OpenGL上下文:

glfwWindowHint(GLFW_CLIENT_API, GLFW_NO_API);

窗口大小变化地处理需要注意很多地方,我们会在以后介绍它,暂时我们先禁止窗口大小改变:

glfwWindowHint(GLFW_RESIZABLE, GLFW_FALSE);

接着,我们添加了一个GLFWwindow* window变量存储我们创建的窗口句柄:

window =glfwCreateWindow(800, 600, "Vulkan", nullptr, nullptr);

glfwCreateWindow函数的前三个参数指定了要创建的窗口的宽度,高度和标题。第四个参数用于指定在哪个显示器上打开窗口,最后一个参数与OpenGL相关,对我们没有意义。

硬编码窗口大小不是一个好习惯,所以我们定义了两个常量,以便之后可以方便地修改它们:

const int WIDTH = 800;

const int HEIGHT = 600;

现在,我们地initWindow函数看起来应该像这样:

void initWindow() {

glfwInit();

glfwWindowHint(GLFW_CLIENT_API, GLFW_NO_API);

glfwWindowHint(GLFW_RESIZABLE, GLFW_FALSE);

window = glfwCreateWindow(WIDTH, HEIGHT, "Vulkan", nullptr, nullptr);

}

为了确保我们的程序在没有发生错误和窗口没有被关闭的情况下可以一直运行,我们在mainLoop函数中添加了下面的事件循环:

void mainLoop() {

while (!glfwWindowShouldClose(window)) {

glfwPollEvents();

}

}

上面的代码应该非常直白,每次循环,检测窗口的关闭按钮是否被按下,如果没有被按下,就执行事件处理,否则结束循环。在之后的章节,我们会在这一循环中调用渲染函数来渲染一帧画面。

一旦窗口关闭,我们就可以开始结束GLFW,然后清除我们自己创建的资源,这在cleanup函数中进行:

void cleanup() {

glfwDestroyWindow(window);

glfwTerminate();

}

至此,我们就编写完成了一个可以使用Vulkan API的窗口程序骨架。

本章节代码:

C++:

https://vulkan-tutorial.com/code/00_base_code.cpp

实例

创建一个实例

我们首先创建一个实例来初始化Vulkan库。这个实例指定了一些驱动程序需要使用的应用程序信息。

我们添加了一个createInstance函数调用到initVulkan函数中:

void initVulkan() {

createInstance();

}

添加了一个存储实例句柄的私有成员:

private:

VkInstance instance;

然后,填写应用程序信息,这些信息的填写不是必须的,但填写的信息可能会作为驱动程序的优化依据,让驱动程序进行一些特殊的优化。比如,应用程序使用了某个引擎,驱动程序对这个引擎有一些特殊处理,这时就可能有很大的优化提升:

VkApplicationInfo appInfo = {};

appInfo.sType = VK_STRUCTURE_TYPE_APPLICATION_INFO;

appInfo.pApplicationName = "Hello Triangle";

appInfo.applicationVersion = VK_MAKE_VERSION(1, 0, 0);

appInfo.pEngineName = "No Engine";

appInfo.engineVersion = VK_MAKE_VERSION(1, 0, 0);

appInfo.apiVersion = VK_API_VERSION_1_0;

之前提到,Vulkan的很多结构体需要我们显式地在sType成员变量中指定结构体的类型。此外,许多Vulkan的结构体还有一个pNext成员变量,用来指向未来可能扩展的参数信息,现在,我们并没有使用它,将其设置为nullptr。

Vulkan倾向于通过结构体传递信息,我们需要填写一个或多个结构体来提供足够的信息创建Vulkan实例。下面的这个结构体是必须的,它告诉Vulkan的驱动程序需要使用的全局扩展和校验层。全局是指这里的设置对于整个应用程序都有效,而不仅仅对一个设备有效,在之后的章节,我们会对此有更加清晰得认识。

VkInstanceCreateInfo createInfo = {};

createInfo.sType = VK_STRUCTURE_TYPE_INSTANCE_CREATE_INFO;

createInfo.pApplicationInfo = &appInfo;

上面代码中填写得两个参数非常直白,不用多解释。接下来,我们需要指定需要的全局扩展。之前提到,Vulkan是平台无关的API,所以需要一个和窗口系统交互的扩展。GLFW库包含了一个可以返回这一扩展的函数,我们可以直接使用它:

uint32_t glfwExtensionCount = 0;

const char** glfwExtensions;

glfwExtensions = glfwGetRequiredInstanceExtensions(&glfwExtensionCount);

createInfo.enabledExtensionCount = glfwExtensionCount;

createInfo.ppEnabledExtensionNames = glfwExtensions;

结构体的最后两个成员变量用来指定全局校验层。我们将在之后的章节更加深入地讨论它,在这里,我们将其设置为0,不使用它:

createInfo.enabledLayerCount = 0;

填写完所有必要的信息,我们就可以调用vkCreateInstance函数来创建Vulkan实例:

VkResult result = vkCreateInstance(&createInfo, nullptr, &instance);

如你所看到的,创建Vulkan对象的函数参数的一般形式就是:

-

一个包含了创建信息的结构体指针

-

一个自定义的分配器回调函数,在本教程,我们没有使用自定义的分配器,总是将它设置为nullptr

-

一个指向新对象句柄存储位置的指针

如果一切顺利,我们创建的实例的句柄就被存储在了类的VkInstance成员变量中。几乎所有Vulkan API函数调用都会返回一个VkResult来反应函数调用的结果,它的值可以是VK_SUCESS表示调用成功,或是一个错误代码,表示调用失败。为了检测实例是否创建成功,我们可以直接将创建函数在条件语句中使用,不需要存储它的返回值:

if (vkCreateInstance(&createInfo, nullptr, &instance) != VK_SUCCESS) {

throw std::runtime_error("failed to create instance!");

}

现在可以编译运行程序来确保实例创建成功。

检测扩展支持

如果读者看过vkCreateInstance函数的官方文档,可能会知道它返回的之中一个错误代码VK_ERROR_EXTENSION_NOT_PRESENT。我们可以利用这个错误代码在扩展不能满足时直接结束我们的程序,这对于像窗口系统这种必要的扩展来说非常适合。但有时,我们请求的扩展可能是非必须的,有了很好,没有的话,程序仍然可以运行,这时,我们该怎么做呢?

实际上Vulkan提供了一个叫做vkEnumerateInstanceExtensionProperties可以在Vulkan实例创建之前返回支持的扩展列表。通过它,我们可以获取扩展的个数,以及扩展的详细信息,此外,它还允许我们指定校验层来对扩展进行过滤,但在这里,我们不使用它,将其设置为nullptr。

我们首先需要知道扩展的数量,以便分配合适的数组大小来存储信息。可以通过下面的代码来获取扩展的数量:

uint32_t extensionCount = 0;

vkEnumerateInstanceExtensionProperties(nullptr, &extensionCount, nullptr);

知道了扩展的数量后,我们就可以分配数组来存储扩展信息:

std::vector<VkExtensionProperties> extensions(extensionCount);

我们使用下面的代码获取所有扩展信息:

vkEnumerateInstanceExtensionProperties(nullptr, &extensionCount, extensions.data());

每个VkExtensionProperties结构体包含了扩展的名字和版本信息。我们可以使用下面的代码将这些信息打印在控制台窗口中(代码中的

t表示制表符):

std::cout << "available extensions:" << std::endl;

for (const auto& extension : extensions) {

std::cout << "\t" << extension.extensionName << std::endl;

}

读者可以将上面的代码加入createInstance函数,获取扩展支持信息。此外,我们可以编写一个函数来检测调用glfwGetRequiredInstanceExtensions函数返回的扩展是否全部包含在了扩展支持列表中。

清理

VkInstance应该在应用程序结束前进行清除操作。我们可以在cleanup中调用vkDestroyInstance函数完成清除工作:

void cleanup() {

vkDestroyInstance(instance, nullptr);

glfwDestroyWindow(window);

glfwTerminate();

}

vkDestroyInstance函数的参数非常直白。之前提到,Vulkan对象的分配和清除函数都有一个可选的分配器回调参数,在本教程,我们没有自定义的分配器,所以,将其设置为nullptr。除了Vulkan实例,其余我们使用Vulkan API创建的对象也需要被清除,且应该在Vulkan实例清除之前被清除。

创建Vulkan实例后,在进行更复杂的操作之前,我们先熟悉一下校验层来帮助我们进行应用程序的调试。

本章节代码:

C++:

https://vulkan-tutorial.com/code/01_instance_creation.cpp

校验层

校验层是什么?

Vulkan API的设计是紧紧围绕最小化驱动程序开销进行的,所以,默认情况下,Vulkan API提供的错误检查功能非常有限。很多很基本的错误都没有被Vulkan显式地处理,遇到错误程序会直接崩溃或者发生未被明确定义的行为。Vukan需要我们显式地定义每一个操作,所以就很容易在使用过程中产生一些小错误,比如使用了一个新的GPU特性,却忘记在逻辑设备创建时请求这一特性。

然而,这并不意味着我们不能将错误检查加入API调用。Vulkan引入了校验层来优雅地解决这个问题。校验层是一个可选的可以用来在Vulkan API函数调用上进行附加操作的组件。校验层常被用来做下面的工作:

-

检测参数值是否合法

-

追踪对象的创建和清除操作,发现资源泄漏问题

-

追踪调用来自的线程,检测是否线程安全。

-

将API调用和调用的参数写入日志

-

追踪API调用进行分析和回放

下面的代码演示了Vulkan的校验层是如何工作的:

VkResult vkCreateInstance(

const VkInstanceCreateInfo* pCreateInfo,

const VkAllocationCallbacks* pAllocator,

VkInstance* instance) {

if (pCreateInfo == nullptr || instance == nullptr) {

log("Null pointer passed to required parameter!");

return VK_ERROR_INITIALIZATION_FAILED;

}

return real_vkCreateInstance(pCreateInfo, pAllocator, instance);

}

校验层可以被自由堆叠包含任何读者感兴趣的调试功能。我们可以在开发时使用校验层,然后在发布应用程序时,禁用校验层来提高程序的运行表现。

Vulkan库本身并没有提供任何内建的校验层,但LunarG的Vulkan SDK提供了一个非常不错的校验层实现。读者可以使用这个校验层实现来保证自己的应用程序在不同的驱动程序下能够尽可能得表现一致,而不是依赖于某个驱动程序的未定义行为。

校验层只能用于安装了它们的系统,比如,LunarG的校验层只可以在安装了Vulkan SDK的PC上使用。

Vulkan可以使用两种不同类型的校验层:实例校验层和设备校验层。实例校验层只检查和全局Vulkan对象相关的调用,比如Vulkan实例。设备校验层只检查和特定GPU相关的调用。设备校验层现在已经不推荐使用,也就是说,应该使用实例校验层来检测所有的Vulkan调用。Vulkan规范文档为了兼容性仍推荐启用设备校验层。在本教程,为了简便,我们为实例和设备指定相同的校验层。

使用校验层

在本章节,我们将使用LunarG的Vulkan SDK提供的校验层。和使用扩展一样,使用校验层需要指定校验层的名称。LunarG的Vulkan SDK允许我们通过VK_LAYER_KHRONOS_validation来隐式地开启所有可用的校验层。

首先,让我们添加两个变量到程序中来控制是否启用指定的校验层。这里,我们通过条件编译来设定是否启用校验层。代码中的NDEBUG宏是C++标准的一部分,表示是否处于非调试模式下:

const int WIDTH = 800;

const int HEIGHT = 600;

const std::vector<const char*> validationLayers = {

"VK_LAYER_KHRONOS_validation"

};

#ifdef NDEBUG

const bool enableValidationLayers = false;

#else

const bool enableValidationLayers = true;

#endif

接着,我们添加了一个叫做checkValidationLayerSupport的函数来请求所有可用的校验层。首先,我们调用vkEnumerateInstanceLayerProperties函数获取了所有可用的校验层列表。这一函数的用法和前面我们在创建Vulkan实例章节中使用的vkEnumerateInstanceExtensionProperties函数相同。

bool checkValidationLayerSupport() {

uint32_t layerCount;

vkEnumerateInstanceLayerProperties(&layerCount, nullptr);

std::vector<VkLayerProperties> availableLayers(layerCount);

vkEnumerateInstanceLayerProperties(&layerCount, availableLayers.data());

return false;

}

接着,检查是否所有validationLayers列表中的校验层都可以在availableLayers列表中找到:

for (const char* layerName : validationLayers) {

bool layerFound = false;

for (const auto& layerProperties : availableLayers) {

if (strcmp(layerName, layerProperties.layerName) == 0) {

layerFound = true;

break;

}

}

if (!layerFound) {

return false;

}

}

return true;

现在,我们在createInstance函数中调用它:

void createInstance() {

if (enableValidationLayers && !checkValidationLayerSupport()) {

throw std::runtime_error("validation layers requested, but not available!");

}

...

}

现在,在调试模式下编译运行程序,确保没有错误出现。如果程序运行时出现错误,请确保正确安装了Vulkan SDK。如果程序报告缺少可用的校验层,可以查阅LunarG的Vulkan SDK的官方文档寻找解决方法。

最后,修改我们之前的填写的VkInstanceCreateInfo结构体信息,在校验层启用时使用校验层:

if (enableValidationLayers) {

createInfo.enabledLayerCount = static_cast<uint32_t>(validationLayers.size());

createInfo.ppEnabledLayerNames = validationLayers.data();

} else {

createInfo.enabledLayerCount = 0;

}

如果校验层检查成功,vkCreateInstance函数调用就不会返回VK_ERROR_LAYER_NOT_PRESENT这一错误代码,但为了保险起见,读者应该运行程序来确保没有问题出现。

消息回调

仅仅启用校验层并没有任何用处,我们不能得到任何有用的调试信息。为了获得调试信息,我们需要使用VK_EXT_debug_utils扩展,设置回调函数来接受调试信息。

我们添加了一个叫做getRequiredExtensions的函数,这一函数根据是否启用校验层,返回所需的扩展列表:

std::vector<const char*> getRequiredExtensions() {

uint32_t glfwExtensionCount = 0;

const char** glfwExtensions;

glfwExtensions = glfwGetRequiredInstanceExtensions(&glfwExtensionCount);

std::vector<const char*> extensions(glfwExtensions,

glfwExtensions + glfwExtensionCount);

if (enableValidationLayers) {

extensions.push_back(VK_EXT_DEBUG_UTILS_EXTENSION_NAME);

}

return extensions;

}

GLFW指定的扩展是必需的,调试报告相关的扩展根据校验层是否启用添加。代码中我们使用了一个VK_EXT_DEBUG_UTILS_EXTENSION_NAME,它等价于VK_EXT_debug_utils,使用它是为了避免打字时的手误。

现在,我们在createInstance函数中调用这一函数:

auto extensions = getRequiredExtensions();

createInfo.enabledExtensionCount = static_cast<uint32_t>(extensions.size());

createInfo.ppEnabledExtensionNames = extensions.data();

接着,编译运行程序,确保没有出现VK_ERROR_EXTENSION_NOT_PRESENT错误。校验层的可用已经隐含说明对应的扩展存在,所以我们不需要额外去做扩展是否存在的检查。

现在,让我们来看接受调试信息的回调函数。我们在程序中以vkDebugUtilsMessengerCallbackEXT为原型添加一个叫做debugCallback的静态函数。这一函数使用VKAPI_ATTR和VKAPI_CALL定义,确保它可以被Vulkan库调用。

static VKAPI_ATTR VkBool32 VKAPI_CALL debugCallback( VkDebugUtilsMessageSeverityFlagBitsEXT messageSeverity, VkDebugUtilsMessageTypeFlagsEXT messageType, const VkDebugUtilsMessengerCallbackDataEXT* pCallbackData, void* pUserData) {

std::cerr << "validation layer: " << pCallbackData->pMessage << std::endl;

return VK_FALSE;

}

函数的第一个参数指定了消息的级别,它可以是下面这些值:

-

VK_DEBUG_UTILS_MESSAGE_SEVERITY_VERBOSE_BIT_EXT:诊断信息

-

VK_DEBUG_UTILS_MESSAGE_SEVERITY_INFO_BIT_EXT:资源创建之类的信息

-

VK_DEBUG_UTILS_MESSAGE_SEVERITY_WARNING_BIT_EXT:警告信息

-

VK_DEBUG_UTILS_MESSAGE_SEVERITY_ERROR_BIT_EXT:不合法和可能造成崩溃的操作信息

这些值经过一定设计,可以使用比较运算符来过滤处理一定级别以上的调试信息:

if (messageSeverity >=VK_DEBUG_UTILS_MESSAGE_SEVERITY_WARNING_BIT_EXT) {

// Message is important enough to show

}

messageType参数可以是下面这些值:

-

VK_DEBUG_UTILS_MESSAGE_TYPE_GENERAL_BIT_EXT:发生了一些与规范和性能无关的事件

-

VK_DEBUG_UTILS_MESSAGE_TYPE_VALIDATION_BIT_EXT:出现了违反规范的情况或发生了一个可能的错误

-

VK_DEBUG_UTILS_MESSAGE_TYPE_PERFORMANCE_BIT_EXT:进行了可能影响Vulkan性能的行为

pCallbackData参数是一个指向VkDebugUtilsMessengerCallbackDataEXT结构体的指针,这一结构体包含了下面这些非常重要的成员:

-

pMessage:一个以null结尾的包含调试信息的字符串

-

pObjects:存储有和消息相关的Vulkan对象句柄的数组

-

objectCount:数组中的对象个数

最后一个参数pUserData是一个指向了我们设置回调函数时,传递的数据的指针。

回调函数返回了一个布尔值,用来表示引发校验层处理的Vulkan API调用是否被中断。如果返回值为true,对应Vulkan API调用就会返回VK_ERROR_VALIDATION_FAILED_EXT错误代码。通常,只在测试校验层本身时会返回true,其余情况下,回调函数应该返回VK_FALSE。

定义完回调函数,接下来要做的就是设置Vulkan使用这一回调函数。我们需要一个VkDebugUtilsMessengerEXT对象来存储回调函数信息,然后将它提交给Vulkan完成回调函数的设置:

VkDebugUtilsMessengerEXT callback;

现在,我们在initVulkan函数中,在createInstance函数调用之后添加一个setupDebugCallback函数调用:

void initVulkan() {

createInstance();

setupDebugCallback();

}

void setupDebugCallback() {

if (!enableValidationLayers) return;

}

接着,我们需要填写VkDebugUtilsMessengerCreateInfoEXT结构体所需的信息:

VkDebugUtilsMessengerCreateInfoEXT createInfo = {};

createInfo.sType = VK_STRUCTURE_TYPE_DEBUG_UTILS_MESSENGER_CREATE_INFO_EXT;

createInfo.messageSeverity = VK_DEBUG_UTILS_MESSAGE_SEVERITY_VERBOSE_BIT_EXT |

VK_DEBUG_UTILS_MESSAGE_SEVERITY_WARNING_BIT_EXT |

VK_DEBUG_UTILS_MESSAGE_SEVERITY_ERROR_BIT_EXT;

createInfo.messageType = VK_DEBUG_UTILS_MESSAGE_TYPE_GENERAL_BIT_EXT |

VK_DEBUG_UTILS_MESSAGE_TYPE_VALIDATION_BIT_EXT |

VK_DEBUG_UTILS_MESSAGE_TYPE_PERFORMANCE_BIT_EXT;

createInfo.pfnUserCallback = debugCallback;

createInfo.pUserData = nullptr; // Optional

messageSeverity域可以用来指定回调函数处理的消息级别。在这里,我们设置回调函数处理除了VK_DEBUG_UTILS_MESSAGE_SEVERITY_INFO_BIT_EXT外的所有级别的消息,这使得我们的回调函数可以接收到可能的问题信息,同时忽略掉冗长的一般调试信息。

messageType域用来指定回调函数处理的消息类型。在这里,我们设置处理所有类型的消息。读者可以根据自己的需要开启和禁用处理的消息类型。

pfnUserCallback域是一个指向回调函数的指针。pUserData是一个指向用户自定义数据的指针,它是可选的,这个指针所指的地址会被作为回调函数的参数,用来向回调函数传递用户数据。

有许多方式配置校验层消息和回调,更多信息可以参考扩展的规范文档。

填写完结构体信息后,我们将它作为一个参数调用vkCreateDebugUtilsMessengerEXT函数来创建VkDebugUtilsMessengerEXT对象。由于vkCreateDebugUtilsMessengerEXT函数是一个扩展函数,不会被Vulkan库自动加载,所以需要我们自己使用vkGetInstanceProcAddr函数来加载它。在这里,我们创建了一个代理函数,来载入vkCreateDebugUtilsMessengerEXT函数:

VkResult CreateDebugUtilsMessengerEXT(VkInstance instance, const VkDebugUtilsMessengerCreateInfoEXT* pCreateInfo, const VkAllocationCallbacks* pAllocator, VkDebugUtilsMessengerEXT* pCallback) {

auto func = (PFN_vkCreateDebugUtilsMessengerEXT)

vkGetInstanceProcAddr(instance, "vkCreateDebugUtilsMessengerEXT");

if (func != nullptr) {

return func(instance, pCreateInfo, pAllocator, pCallback);

} else {

return VK_ERROR_EXTENSION_NOT_PRESENT;

}

}

vkGetInstanceProcAddr函数如果不能被加载,那么我们的代理函数就会发挥nullptr。现在我们可以使用这个代理函数来创建扩展对象:

if (CreateDebugUtilsMessengerEXT(instance, &createInfo, nullptr,

&callback) != VK_SUCCESS) {

throw std::runtime_error("failed to set up debug callback!");

}

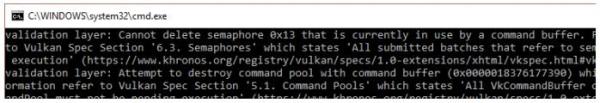

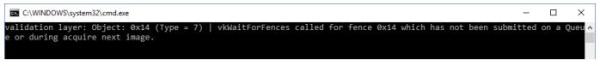

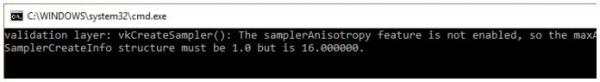

函数的第二个参数是可选的分配器回调函数,我们没有自定义的分配器,所以将其设置为nullptr。由于我们的调试回调是针对特定Vulkan实例和它的校验层,所以需要在第一个参数指定调试回调作用的Vulkan实例。现在,让我们编译运行程序,如果一切顺利,读者可以看到一个空白窗口,关闭空白窗口后,可以在控制台窗口看到下面的信息:

这说明,我们的程序还存在问题!VkDebugUtilsMessengerEXT对象在程序结束前通过调用vkDestroyDebugUtilsMessengerEXT函数来清除掉。和vkCreateDebugUtilsMessengerEXT函数相同,Vulkan库没有自动加载这个函数,需要我们自己加载它。控制台窗口出现多次相同的错误信息是正常的,这是因为有多个校验层检查发现了这个问题。

现在,让我们创建CreateDebugUtilsMessengerEXT函数的代理函数:

void DestroyDebugUtilsMessengerEXT(VkInstance instance, VkDebugUtilsMessengerEXT callback, const VkAllocationCallbacks* pAllocator) {

auto func = (PFN_vkDestroyDebugUtilsMessengerEXT) vkGetInstanceProcAddr(instance, "vkDestroyDebugUtilsMessengerEXT");

if (func != nullptr) {

func(instance, callback, pAllocator);

}

}

这个代理函数需要被定义为类的静态成员函数或者被定义在类之外。我们在cleanup函数中调用这个函数:

void cleanup() {

if (enableValidationLayers) {

DestroyDebugUtilsMessengerEXT(instance, callback, nullptr);

}

vkDestroyInstance(instance, nullptr);

glfwDestroyWindow(window);

glfwTerminate();

}

现在,再次编译运行程序,如果一切顺利,错误信息这次就不会出现。如果读者想要了解到底是哪个函数调用引发了错误消息,可以在处理消息的回调函数设置断点,然后运行程序,观察程序在断点位置时的调用栈,就可以确定引发错误消息的函数调用。

配置

校验层除了VkDebugUtilsMessengerCreateInfoEXT结构体指定的标志外,还有大量可以决定校验层行为的设置。读者可以浏览Vulkan SDK的Config目录,里面有一个vk_layer_settings.txt解释了如何配置校验层。

读者可以将vk_layer_settings.txt 复制到自己的项目的Debug和Release目录来使用它,并按照说明根据需要修改设置。在本教程,我们只使用vk_layer_settings.txt的默认设置。

在之后的章节,我们会故意造成一些错误,来演示如何使用校验层来发现这些错误,帮助读者理解校验层的重要性。现在,是时候来看一看系统中的Vulkan设备了。

本章节代码:

C++:

https://vulkan-tutorial.com/code/02_validation_layers.cpp

物理设备和队列族

选择一个物理设备

创建VkInstance后,我们需要查询系统中的显卡设备,选择一个支持我们需要的特性的设备使用。Vulkan允许我们选择任意数量的显卡设备,并能够同时使用它们,但在这里,我们只使用第一个满足我们需求的显卡设备。

我们首先添加一个叫做pickPhysicalDevice的函数,然后在initVulkan函数中调用它:

void initVulkan() {

createInstance();

setupDebugCallback();

pickPhysicalDevice();

}

void pickPhysicalDevice() {

}

我们使用VkPhysicalDevice对象来存储我们选择使用的显卡信息。这一对象可以在VkInstance进行清除操作时,自动清除自己,所以我们不需要再cleanup函数中对它进行清除。

VkPhysicalDevice physicalDevice = VK_NULL_HANDLE;

请求显卡列表和请求扩展列表的操作类似,首先需要请求显卡的数量。

uint32_t deviceCount = 0;

vkEnumeratePhysicalDevices(instance, &deviceCount, nullptr);

如果可用的显卡设备数量为0,显然应用程序无法继续运行。

if (deviceCount == 0) {

throw std::runtime_error("failed to find GPUs with Vulkan support!");

}

获取完设备数量后,我们就可以分配数组来存储VkPhysicalDevice对象。

std::vector<VkPhysicalDevice> devices(deviceCount);

vkEnumeratePhysicalDevices(instance, &deviceCount, devices.data());

现在,让我们检查获取的设备能否满足我们的需求:

bool isDeviceSuitable(VkPhysicalDevice device) {

return true;

}

我们检查设备,并选择使用第一个满足需求的设备:

for (const auto& device : devices) {

if (isDeviceSuitable(device)) {

physicalDevice = device;

break;

}

}

if (physicalDevice == VK_NULL_HANDLE) {

throw std::runtime_error("failed to find a suitable GPU!");

}

下一节,我们开始具体说明isDeviceSuitable函数所进行的检查,随着我们使用的特性增多,这一函数所包含的检查也越来越多。

设备需求检测

为了选择合适的设备,我们需要获取更加详细的设备信息。对于基础的设备属性,比如名称,类型和支持的Vulkan版本的查询可以通过vkGetPhysicalDeviceProperties函数进行。

VkPhysicalDeviceProperties deviceProperties;

vkGetPhysicalDeviceProperties(device, &deviceProperties);

纹理压缩,64位浮点和多视口渲染(常用于VR)等特性的支持可以通过vkGetPhysicalDeviceFeatures函数查询:

VkPhysicalDeviceFeatures deviceFeatures;

vkGetPhysicalDeviceFeatures(device, &deviceFeatures);

有关设备内存和队列族信息的获取,我们会在下一节说明。

现在,假设我们的应用程序只有在显卡支持几何着色器的情况下才可以运行,那么我们的isDeviceSuitable函数看起来会像这样:

bool isDeviceSuitable(VkPhysicalDevice device) {

VkPhysicalDeviceProperties deviceProperties;

VkPhysicalDeviceFeatures deviceFeatures;

vkGetPhysicalDeviceProperties(device, &deviceProperties);

vkGetPhysicalDeviceFeatures(device, &deviceFeatures);

return deviceProperties.deviceType == VK_PHYSICAL_DEVICE_TYPE_DISCRETE_GPU && deviceFeatures.geometryShader;

}

除了直接选择第一个满足需求的设备这种方法,一个更好的方法是给每一个满足需求的设备,按照特性加权打分,选择分数最高的设备使用。具体可以这样做:

#include <map>

...

void pickPhysicalDevice() {

...

// Use an ordered map to automatically sort candidates by increasing score

std::multimap<int, VkPhysicalDevice> candidates;

for (const auto& device : devices) {

int score = rateDeviceSuitability(device);

candidates.insert(std::make_pair(score, device));

}

// Check if the best candidate is suitable at all

if (candidates.rbegin()->first > 0) {

physicalDevice = candidates.rbegin()->second;

} else {

throw std::runtime_error("failed to find a suitable GPU!");

}

}

int rateDeviceSuitability(VkPhysicalDevice device) {

...

int score = 0;

// Discrete GPUs have a significant performance advantage

if (deviceProperties.deviceType == VK_PHYSICAL_DEVICE_TYPE_DISCRETE_GPU) {

score += 1000;

}

// Maximum possible size of textures affects graphics quality

score += deviceProperties.limits.maxImageDimension2D;

// Application can't function without geometry shaders

if (!deviceFeatures.geometryShader) {

return 0;

}

return score;

}

此外,也可以显示满足需求的设备列表,让用户自己选择使用的设备。

由于我们的教程才刚刚开始,我们现在的唯一需求就是显卡设备需要支持Vulkan,显然它对于我们使用Vulkan API获取的设备列表中的所有设备都永远满足:

队列族

之前提到,Vulkan的几乎所有操作,从绘制到加载纹理都需要将操作指令提交给一个队列,然后才能执行。Vulkan有多种不同类型的队列,它们属于不同的队列族,每个队列族的队列只允许执行特定的一部分指令。比如,可能存在只允许执行计算相关指令的队列族和只允许执行内存传输相关指令的队列族。

我们需要检测设备支持的队列族,以及它们中哪些支持我们需要使用的指令。为了完成这一目的,我们添加了一个叫做findQueueFamilies的函数,这一函数会查找出满足我们需求的队列族。目前而言,我们需要的队列族只需要支持图形指令即可,但在之后的章节,我们可能会有更多的需求。

这一函数会返回满足需求得队列族的索引。这里,我们使用了一个结构体来作为函数返回结果的类型,索引-1表示没有找到满足需求的队列族:

struct QueueFamilyIndices {

int graphicsFamily = -1;

bool isComplete() {

return graphicsFamily >= 0;

}

};

接下来,我们实现findQueueFamilies函数:

QueueFamilyIndices findQueueFamilies(VkPhysicalDevice device) {

QueueFamilyIndices indices;

...

return indices;

}

我们首先获取设备的队列族个数,然后分配数组存储队列族的VkQueueFamilyProperties对象:

uint32_t queueFamilyCount = 0;

vkGetPhysicalDeviceQueueFamilyProperties(device, &queueFamilyCount, nullptr);

std::vector<VkQueueFamilyProperties> queueFamilies(queueFamilyCount);

vkGetPhysicalDeviceQueueFamilyProperties(device, &queueFamilyCount, queueFamilies.data());

VkQueueFamilyProperties结构体包含了队列族的很多信息,比如支持的操作类型,该队列族可以创建的队列个数。在这里,我们需要找到一个支持VK_QUEUE_GRAPHICS_BIT的队列族。

int i = 0;

for (const auto& queueFamily : queueFamilies) {

if (queueFamily.queueCount > 0 && queueFamily.queueFlags & VK_QUEUE_GRAPHICS_BIT) {

indices.graphicsFamily = i;

}

if (indices.isComplete()) {

break;

}

i++;

}

现在,我们可以在isDeviceSuitable函数中调用它来确保我们选择的设备可以执行我们需要的指令:

bool isDeviceSuitable(VkPhysicalDevice device) {

QueueFamilyIndices indices = findQueueFamilies(device);

return indices.isComplete();

}

太棒了!我们已经完成了查找我们需要的物理设备这一工作!接下来,让我们创建逻辑设备来使用它!

本章节代码:

C++:

https://vulkan-tutorial.com/code/03_physical_device_selection.cpp

逻辑设备和队列

介绍

选择物理设备后,我们还需要一个逻辑设备来作为和物理设备交互的接口。逻辑设备的创建过程类似于我们之前描述的Vulkan实例的创建过程。我们还需要指定使用的队列所属的队列族。对于同一个物理设备,我们可以根据需求的不同,创建多个逻辑设备。

首先,我们添加一个逻辑设备对象作为类成员:

VkDevice device;

接着,添加一个叫做createLogicalDevice的函数,在initVulkan函数中调用它。

void initVulkan() {

createInstance();

setupDebugCallback();

pickPhysicalDevice();

createLogicalDevice();

}

void createLogicalDevice() {

}

指定要创建的队列

逻辑设备创建需要填写VkDeviceQueueCreateInfo结构体。这一结构体描述了针对一个队列族我们所需的队列数量。目前而言,我们只使用了带有图形能力的队列族。

QueueFamilyIndices indices = findQueueFamilies(physicalDevice);

VkDeviceQueueCreateInfo queueCreateInfo = {};

queueCreateInfo.sType = VK_STRUCTURE_TYPE_DEVICE_QUEUE_CREATE_INFO;

queueCreateInfo.queueFamilyIndex = indices.graphicsFamily;

queueCreateInfo.queueCount = 1;

目前而言,对于每个队列族,驱动程序只允许创建很少数量的队列,但实际上,对于每一个队列族,我们很少需要一个以上的队列。我们可以在多个线程创建指令缓冲,然后在主线程一次将它们全部提交,降低调用开销。

Vulkan需要我们赋予队列一个0.0到1.0之间的浮点数作为优先级来控制指令缓冲的执行顺序。即使只有一个队列,我们也要显式地赋予队列优先级:

float queuePriority = 1.0f;

queueCreateInfo.pQueuePriorities = &queuePriority;

指定使用的设备特性

接下来,我们要指定应用程序使用的设备特性。我们暂时先简单地定义它,之后再回来填写:

VkPhysicalDeviceFeatures deviceFeatures = {};

创建逻辑设备

填写好前面两个结构体后,我们可以开始填写VkDeviceCreateInfo结构体。

VkDeviceCreateInfo createInfo = {};

createInfo.sType = VK_STRUCTURE_TYPE_DEVICE_CREATE_INFO;

将VkDeviceCreateInfo结构体的pQueueCreateInfos指针指向queueCreateInfo的地址,pEnabledFeatures指针指向deviceFeatures的地址:

createInfo.pQueueCreateInfos = &queueCreateInfo;

createInfo.queueCreateInfoCount = 1;

createInfo.pEnabledFeatures = &deviceFeatures;

结构体的其余成员和VkInstanceCreateInfo类似,不同的是这次的设置是针对设备的。

VK_KHR_swapchain就是一个设备特定扩展的例子,这一扩展使得我们可以将渲染的图像在窗口上显示出来。看起来似乎应该所有支持Vulkan的设备都应该支持这一扩展,然而,实际上有的Vulkan设备只支持计算指令,不支持这一图形相关扩展。在之后的章节,我们会对交换链进行更加深入地说明。

之前提到,我们可以对设备和Vulkan实例使用相同地校验层,不需要额外的扩展支持:

createInfo.enabledExtensionCount = 0;

if (enableValidationLayers) {

createInfo.enabledLayerCount = static_cast<uint32_t>(validationLayers.size());

createInfo.ppEnabledLayerNames = validationLayers.data();

} else {

createInfo.enabledLayerCount = 0;

}

现在,我们可以调用vkCreateDevice函数创建逻辑设备了。

if (vkCreateDevice(physicalDevice, &createInfo, nullptr, &device) != VK_SUCCESS) {

throw std::runtime_error("failed to create logical device!");

}

vkCreateDevice函数的参数包括我们创建的逻辑设备进行交互的物理设备对象,我们刚刚在结构体中指定的需要使用的队列信息,可选的分配器回调,以及用来存储返回的逻辑设备对象的内存地址。和Vulkan实例对象的创建函数类似,这一函数调用在请求的设备需求不被满足时返回错误代码。

逻辑设备对象创建后,应用程序结束前,需要我们自己在cleanup函数中调用vkDestroyDevice函数来清除它:

void cleanup() {

vkDestroyDevice(device, nullptr);

...

}

逻辑设备并不直接与Vulkan实例交互,所以创建逻辑设备时不需要使用Vulkan实例作为参数。

获取队列句柄

创建逻辑设备时指定的队列会随着逻辑设备一同被创建,为了方便,我们添加了一个VkQueue成员变量来直接存储逻辑设备的队列句柄:

VkQueue graphicsQueue;

逻辑设备的队列会在逻辑设备清除时,自动被清除,所以不需要我们在cleanup函数中进行队列的清除操作。

vkGetDeviceQueue函数可以获取指定队列族的队列句柄。它的参数依次是逻辑设备对象,队列族索引,队列索引,用来存储返回的队列句柄的内存地址。因为,我们只创建了一个队列,所以,可以直接使用索引0调用函数:

vkGetDeviceQueue(device, indices.graphicsFamily, 0, &graphicsQueue);

创建完逻辑设备,我们就可以真正开始使用显卡来完成一些操作。在接下来的章节,我们将开始配置资源,进行一些绘制操作,将渲染结果显示在窗口上。

本章节代码:

C++:

https://vulkan-tutorial.com/code/04_logical_device.cpp

窗口表面

Vulkan是一个平台无关的API,它不能直接和窗口系统交互。为了将Vulkan渲染的图像显示在窗口上,我们需要使用WSI(Window System Integration)扩展。在本章节,我们首先介绍VK_KHR_surface扩展,它通过VkSurfaceKHR对象抽象出可供Vulkan渲染的表面。在本教程,我们使用GLFW来获取VkSurfaceKHR对象。

VK_KHR_surface是一个实例级别的扩展,它已经被包含在使用glfwGetRequiredInstanceExtensions函数获取的扩展列表中,所以,我们不需要自己请求这一扩展。WSI扩展同样也被包含在glfwGetRequiredInstanceExtensions函数获取的扩展列表中,也不需要我们自己请求。

由于窗口表面对物理设备的选择有一定影响,它的创建只能在Vulkan实例创建之后进行。

创建窗口表面

VkSurfaceKHR surface;

尽管VkSurfaceKHR对象是平台无关的,但它的创建依赖窗口系统。比如,在Windows系统上,它的创建需要HWND和HMODULE。存在一个叫做VK_KHR_win32_surface的Windows平台特有扩展,用于处理与Windows系统窗口交互有关的问题,这一扩展也被包含在了glfwGetRequiredInstanceExtensions函数获取的扩展列表中。

接下来,我们将会演示如何使用这一Windows系统特有扩展来创建表面,但对于之后的章节,我们不会使用这一特定平台扩展,而是直接使用GLFW库来完成相关操作。我们可以使用GLFW库的glfwCreateWindowSurface函数来完成表面创建。这里演示如何使用这一平台特定扩展,是出于学习目的,让读者能明白我们使用的GLFW库在背后究竟做了什么。

我们需要填写VkWin32SurfaceCreateInfoKHR结构体来完成VkSurfaceKHR对象的创建。这一结构体包含了两个非常重要的成员:hwnd和hinstance。它们分别对应Windows系统的窗口句柄和进程实例句柄:

VkWin32SurfaceCreateInfoKHR createInfo = {};

createInfo.sType = VK_STRUCTURE_TYPE_WIN32_SURFACE_CREATE_INFO_KHR;

createInfo.hwnd = glfwGetWin32Window(window);

createInfo.hinstance = GetModuleHandle(nullptr);

glfwGetWin32Window函数可以获取GLFW窗口对象的Windows平台窗口句柄。GetModuleHandle函数可以获取当前进程的实例句柄。

vkCreateWin32SurfaceKHR函数需要我们自己加载。加载后使用Vulkan实例,要创建的表面信息,自定义内存分配器和要存储表面对象的内存地址为参数调用:

auto CreateWin32SurfaceKHR = (PFN_vkCreateWin32SurfaceKHR) vkGetInstanceProcAddr(instance, "vkCreateWin32SurfaceKHR");

if (!CreateWin32SurfaceKHR || CreateWin32SurfaceKHR(instance, &createInfo, nullptr, &surface) != VK_SUCCESS) {

throw std::runtime_error("failed to create window surface!");

}

其它平台的处理方式与之类似,比如Linux平台,可以通过vkCreateXcbSurfaceKHR函数完成表面创建的工作。

GLFW库的glfwCreateWindowSurface函数在不同平台的实现是不同的,可以跨平台使用。现在,我们将它集成到我们的应用程序中。添加一个叫做createSurface的函数,然后在initVulkan函数中在Vulkan实例创建和setupDebugCallback调用之后调用它:

void initVulkan() {

createInstance();

setupDebugCallback();

createSurface();

pickPhysicalDevice();

createLogicalDevice();

}

void createSurface() {

}

glfwCreateWindowSurface函数的参数非常直白:

void createSurface() {

if (glfwCreateWindowSurface(instance, window, nullptr, &surface) != VK_SUCCESS) {

throw std::runtime_error("failed to create window surface!");

}

}

它的参数依次是VkInstance对象,GLFW窗口指针,自定义内存分配器,存储返回的VkSurfaceKHR对象的内存地址。调用后,它会返回VkResult来指示创建是否成功。表面在应用程序退出需要被清理,GLFW并没有提供清除表面的函数,我们可以自己调用vkDestroySurfaceKHR函数完成这一工作:

void cleanup() {

...

vkDestroySurfaceKHR(instance, surface, nullptr);

vkDestroyInstance(instance, nullptr);

...

}

需要注意,表面对象的清除需要在Vulkan实例被清除之前完成。

查询呈现支持

尽管,具体的Vulkan实现可能对窗口系统进行了支持,但这并不意味着所有平台的Vulkan实现都支持同样的特性。所以,我们需要扩展isDeviceSuitable函数来确保设备可以在我们创建的表面上显示图像。

实际上,支持绘制指令的队列族和支持表现的队列族并不一定重叠。所以,我们需要修改QueueFamilyIndices结构体,添加成员变量存储表现队列族的索引:

struct QueueFamilyIndices {

int graphicsFamily = -1;

int presentFamily = -1;

bool isComplete() {

return graphicsFamily >= 0 && presentFamily >= 0;

}

};

接着,我们还需要修改findQueueFamilies函数,查找带有呈现图像到窗口表面能力的队列族。我们可以在检查队列族是否具有VK_QUEUE_GRAPHICS_BIT的同级循环调用vkGetPhysicalDeviceSurfaceSupportKHR函数来检查物理设备是否具有呈现能力:

VkBool32 presentSupport = false;

vkGetPhysicalDeviceSurfaceSupportKHR(device, i, surface, &presentSupport);

然后,根据队列族中的队列数量和是否支持表现确定使用的表现队列族的索引:

if (queueFamily.queueCount > 0 && presentSupport) {

indices.presentFamily = i;

}

读者可能已经注意到,按照上面的方法最后选择使用的绘制指令队列族和呈现队列族很有可能是同一个队列族。但为了统一操作,即使两者是同一个队列族,我们也按照它们是不同的队列族来对待。实际上,读者可以显式地指定绘制和呈现队列族是同一个的物理设备来提高性能表现。

创建呈现队列

现在,我们可以修改逻辑设备的创建过程,创建呈现队列,并将队列句柄保存在成员变量中:

VkQueue presentQueue;

我们需要多个VkDeviceQueueCreateInfo结构体来创建所有使用的队列族。一个优雅的处理方式是使用STL的集合创建每一个不同的队列族:

#include <set>

...

QueueFamilyIndices indices = findQueueFamilies(physicalDevice);

std::vector<VkDeviceQueueCreateInfo> queueCreateInfos;

std::set<int> uniqueQueueFamilies = {indices.graphicsFamily, indices.presentFamily};

float queuePriority = 1.0f;

for (int queueFamily : uniqueQueueFamilies) {

VkDeviceQueueCreateInfo queueCreateInfo = {};

queueCreateInfo.sType = VK_STRUCTURE_TYPE_DEVICE_QUEUE_CREATE_INFO;

queueCreateInfo.queueFamilyIndex = queueFamily;

queueCreateInfo.queueCount = 1;

queueCreateInfo.pQueuePriorities = &queuePriority;

queueCreateInfos.push_back(queueCreateInfo);

}

修改VkDeviceCreateInfo结构体的pQueueCreateInfos:

createInfo.queueCreateInfoCount = static_cast<uint32_t>(queueCreateInfos.size());

createInfo.pQueueCreateInfos = queueCreateInfos.data();

对于同一个队列族,我们只需要传递它的索引一次。最后,调用vkGetDeviceQueue函数获取队列句柄:

vkGetDeviceQueue(device, indices.presentFamily, 0, &presentQueue);

对于队列族相同的情况,我们获取的队列句柄也极有可能相同。在下一章节,我们将介绍交换链,以及如何使用它将图像显示到窗口表面上。

本章节代码:

C++:

https://vulkan-tutorial.com/code/05_window_surface.cpp

交换链

Vulkan没有默认帧缓冲的概念,它需要一个能够缓冲渲染操作的组件。在Vulkan中,这一组件就是交换链。Vulkan的交换链必须显式地创建,不存在默认的交换链。交换链本质上一个包含了若干等待呈现的图像的队列。我们的应用程序从交换链获取一张图像,然后在图像上进行渲染操作,完成后,将图像返回到交换链的队列中。交换链的队列的工作方式和它呈现图像到表面的条件依赖于交换链的设置。但通常来说,交换链被用来同步图像呈现和屏幕刷新。

检测交换链支持

并不是所有的显卡设备都具有可以直接将图像呈现到屏幕的能力。比如,被设计用于服务器的显卡是没有任何显示输出设备的。此外,由于图像呈现非常依赖窗口系统,以及和窗口系统有关的窗口表面,这些并非Vulkan核心的一部分。使用交换链,我们必须保证VK_KHR_swapchain设备扩展被启用。

为了确保VK_KHR_swapchain设备扩展被设备支持,我们需要扩展VK_KHR_swapchain函数检测该扩展是否被支持。之前,我们已经介绍了列出VkPhysicalDevice对象支持的扩展列表的方法,现在只需要在这个列表中检测是否存在VK_KHR_swapchain扩展即可。Vulkan的头文件提供了一个叫做VK_KHR_SWAPCHAIN_EXTENSION_NAME的宏,它等价于VK_KHR_swapchain。我们使用这个宏来做检测,而不直接使用VK_KHR_swapchain,可以保证代码具有更好的兼容性。

首先,我们定义所需的的设备扩展列表,这类似于我们之前定义的要启用的校验层列表。

const std::vector<const char*> deviceExtensions = {

VK_KHR_SWAPCHAIN_EXTENSION_NAME

};

接着,添加一个叫做checkDeviceExtensionSupport的函数,然后在isDeviceSuitable函数中调用它:

bool isDeviceSuitable(VkPhysicalDevice device) {

QueueFamilyIndices indices = findQueueFamilies(device);

bool extensionsSupported = checkDeviceExtensionSupport(device);

return indices.isComplete() && extensionsSupported;

}

bool checkDeviceExtensionSupport(VkPhysicalDevice device) {

return true;

}

修改checkDeviceExtensionSupport函数的函数体枚举设备扩展列表,检测所需的扩展是否存在:

bool checkDeviceExtensionSupport(VkPhysicalDevice device) {

uint32_t extensionCount;

vkEnumerateDeviceExtensionProperties(device, nullptr, &extensionCount, nullptr);

std::vector<VkExtensionProperties> availableExtensions(extensionCount);

vkEnumerateDeviceExtensionProperties(device, nullptr, &extensionCount, availableExtensions.data());

std::set<std::string> requiredExtensions(deviceExtensions.begin(), deviceExtensions.end());

for (const auto& extension : availableExtensions) {

requiredExtensions.erase(extension.extensionName);

}

return requiredExtensions.empty();

}

在这里,我们将所需的扩展保存在一个集合中,然后枚举所有可用的扩展,将集合中的扩展剔除,最后,如果这个集合中的元素为0,说明我们所需的扩展全部都被满足。实际上,如果设备支持呈现队列,那么它就一定支持交换链。但我们最好还是显式地进行交换链扩展的检测,然后显式地启用交换链扩展。

启用交换链扩展,只需要对逻辑设备的创建过程做很小地修改:

createInfo.enabledExtensionCount = static_cast<uint32_t>(deviceExtensions.size());

createInfo.ppEnabledExtensionNames = deviceExtensions.data();

查询交换链支持细节

只检查交换链是否可用还不够,交换链可能与我们的窗口表面不兼容。创建交换链所要进行的设置要比Vulkan实例和设备创建多得多,在进行交换链创建之前需要我们查询更多的信息。

有三种最基本的属性,需要我们检查:

-

基础表面特性(交换链的最小/最大图像数量,最小/最大图像宽度、高度)

-

表面格式(像素格式,颜色空间)

-

可用的呈现模式

和findQueueFamilies函数类似,我们使用结构体来存储我们查询得到的交换链细节信息:

struct SwapChainSupportDetails {

VkSurfaceCapabilitiesKHR capabilities;

std::vector<VkSurfaceFormatKHR> formats;

std::vector<VkPresentModeKHR> presentModes;

};

现在,我们添加一个叫做querySwapChainSupport的函数用于填写上面的结构体:

SwapChainSupportDetails querySwapChainSupport(VkPhysicalDevice device) {

SwapChainSupportDetails details;

return details;

}

在本节,我们先介绍如何查询上面的结构体所包含的信息,在下一节再对它们的具体意义进行说明。

我们先查询基础表面特性。这一属性的查询非常简单,调用下面的函数即可:

vkGetPhysicalDeviceSurfaceCapabilitiesKHR(device, surface, &details.capabilities);

这一函数以VkPhysicalDevice对象和VkSurfaceKHR作为参数来查询表面特性。与交换链信息查询有关的函数都需要这两个参数,它们是交换链的核心组件。

下一步,我们查询表面支持的格式。这一查询结果是一个结构体列表,所以它的查询与之前设备特性查询类似,首先查询格式数量,然后分配数组空间查询具体信息:

uint32_t formatCount;

vkGetPhysicalDeviceSurfaceFormatsKHR(device, surface, &formatCount, nullptr);

if (formatCount != 0) {

details.formats.resize(formatCount);

vkGetPhysicalDeviceSurfaceFormatsKHR(device, surface, &formatCount, details.formats.data());

}

确保向量的空间足以容纳所有格式结构体。最后,使用与调用vkGetPhysicalDeviceSurfacePresentModesKHR函数同样的方式查询支持的呈现模式:

uint32_t presentModeCount;

vkGetPhysicalDeviceSurfacePresentModesKHR(device, surface, &presentModeCount, nullptr);

if (presentModeCount != 0) {

details.presentModes.resize(presentModeCount);

vkGetPhysicalDeviceSurfacePresentModesKHR(device, surface, &presentModeCount, details.presentModes.data());

}

现在所有查询得到的信息已经存储在了结构体中,我可以再次扩展isDeviceSuitable函数检测交换链的能力是否满足需求。对于我们的教程而言,我们只需要交换链至少支持一种图像格式和一种支持我们的窗口表面的呈现模式即可:

bool swapChainAdequate = false;

if (extensionsSupported) {

SwapChainSupportDetails swapChainSupport = querySwapChainSupport(device);

swapChainAdequate = !swapChainSupport.formats.empty() && !swapChainSupport.presentModes.empty();

}

我们只能在验证交换链扩展可用后查询交换链的细节信息。isDeviceSuitable函数的最后一行需要修改为:

return indices.isComplete() && extensionsSupported && swapChainAdequate;

为交换链选择合适的设置

swapChainAdequate为真,说明交换链的能力满足我们的需要,但仍有许多不同的优化模式需要设置。接下来,我们会编写一组函数来查找合适的设置。设置的内容如下:

-

表面格式(颜色,深度)

-

呈现模式(显示图像到屏幕的条件)

-

交换范围(交换链中的图像的分辨率)

对于上面的设置,每一个我们都有一个理想的值,如果这个理想的值不能满足,我们会使用编写的逻辑查找一个尽可能好的替代值。

表面格式

我们添加了一个叫做chooseSwapSurfaceFormat的函数来选择合适的表面格式:

VkSurfaceFormatKHR chooseSwapSurfaceFormat(const std::vector<VkSurfaceFormatKHR> &availableFormats) {

}

每一个VkSurfaceFormatKHR条目包含了一个format和colorSpace成员变量。format成员变量用于指定颜色通道和存储类型。比如,如果fomat成员变量的值为VK_FORMAT_B8G8R8A8_UNORM表示我们以B,G,R和A的顺序,每个颜色通道用8位无符号整型数表示,总共每像素使用32位表示。colorSpace成员变量用来表示SRGB颜色空间是否被支持,是否使用VK_COLOR_SPACE_SRGB_NONLINEAR_KHR标志。需要注意VK_COLOR_SPACE_SRGB_NONLINEAR_KHR在之前的Vulkan规范中叫做VK_COLORSPACE_SRGB_NONLINEAR_KHR。

对于颜色空间,如果SRGB被支持,我们就使用SRGB,使用它可以得到更加准确的颜色表示。直接使用SRGB颜色有很大挑战,所以我们使用RGB作为颜色格式,这一格式可以通过VK_FORMAT_B8G8R8A8_UNORM宏指定。

Vulkan通过返回一个format成员变量值为VK_FORMAT_UNDEFINED的VkSurfaceFormatKHR表明表面没有自己的首选格式,这时,我们直接返回我们设定的格式:

if (availableFormats.size() == 1 && availableFormats[0].format == VK_FORMAT_UNDEFINED) {

return {VK_FORMAT_B8G8R8A8_UNORM, VK_COLOR_SPACE_SRGB_NONLINEAR_KHR};

}

如果Vulkan返回了一个格式列表,那么我们检查这个列表,看下我们想要设定的格式是否存在于这个列表中:

for (const auto& availableFormat : availableFormats) {

if (availableFormat.format == VK_FORMAT_B8G8R8A8_UNORM && availableFormat.colorSpace == VK_COLOR_SPACE_SRGB_NONLINEAR_KHR) {

return availableFormat;

}

}

如果不能在列表中找到我们想要的格式,我们可以对列表中存在的格式进行打分,选择分数最高的那个作为我们使用的格式,当然,大多数情况下,直接使用列表中的第一个格式也是非常不错的选择:

VkSurfaceFormatKHR chooseSwapSurfaceFormat(const std::vector<VkSurfaceFormatKHR> &availableFormats) {

if (availableFormats.size() == 1 && availableFormats[0].format == VK_FORMAT_UNDEFINED) {

return {VK_FORMAT_B8G8R8A8_UNORM, VK_COLOR_SPACE_SRGB_NONLINEAR_KHR};

}

for (const auto& availableFormat : availableFormats) {

if (availableFormat.format == VK_FORMAT_B8G8R8A8_UNORM && availableFormat.colorSpace == VK_COLOR_SPACE_SRGB_NONLINEAR_KHR){

return availableFormat;

}

}

return availableFormats[0];

}

呈现模式

呈现模式可以说是交换链中最重要的设置。它决定了什么条件下图像才会显示到屏幕。Vulkan提供了四种可用的呈现模式:

-

VK_PRESENT_MODE_IMMEDIATE_KHR:应用程序提交的图像会被立即传输到屏幕上,可能会导致撕裂现象。

-

VK_PRESENT_MODE_FIFO_KHR:交换链变成一个先进先出的队列,每次从队列头部取出一张图像进行显示,应用程序渲染的图像提交给交换链后,会被放在队列尾部。当队列为满时,应用程序需要进行等待。这一模式非常类似现在常用的垂直同步。刷新显示的时刻也被叫做垂直回扫。

-

VK_PRESENT_MODE_FIFO_RELAXED_KHR:这一模式和上一模式的唯一区别是,如果应用程序延迟,导致交换链的队列在上一次垂直回扫时为空,那么,如果应用程序在下一次垂直回扫前提交图像,图像会立即被显示。这一模式可能会导致撕裂现象。

-

VK_PRESENT_MODE_MAILBOX_KHR:这一模式是第二种模式的另一个变种。它不会在交换链的队列满时阻塞应用程序,队列中的图像会被直接替换为应用程序新提交的图像。这一模式可以用来实现三倍缓冲,避免撕裂现象的同时减小了延迟问题。

上面四种呈现模式,只有VK_PRESENT_MODE_FIFO_KHR模式保证一定可用,所以我们还需要编写一个函数来查找最佳的可用呈现模式:

VkPresentModeKHR chooseSwapPresentMode(const std::vector<VkPresentModeKHR> availablePresentModes) {

return VK_PRESENT_MODE_FIFO_KHR;

}

作者个人认为三倍缓冲综合来说表现最佳。三倍缓冲避免了撕裂现象,同时具有较低的延迟。我们检查用于实现三倍缓冲的VK_PRESENT_MODE_MAILBOX_KHR模式是否可用,可用的话,就使用它:

VkPresentModeKHR chooseSwapPresentMode(const std::vector<VkPresentModeKHR> availablePresentModes) {

for (const auto& availablePresentMode : availablePresentModes) {

if (availablePresentMode == VK_PRESENT_MODE_MAILBOX_KHR)

{

return availablePresentMode;

}

}

return VK_PRESENT_MODE_FIFO_KHR;

}

不幸的是,目前而言,还有许多驱动程序对VK_PRESENT_MODE_FIFO_KHR呈现模式的支持不够好,所以,如果VK_PRESENT_MODE_MAILBOX_KHR呈现模式不可用,我们应该使用VK_PRESENT_MODE_IMMEDIATE_KHR模式:

VkPresentModeKHR chooseSwapPresentMode(const std::vector<VkPresentModeKHR> availablePresentModes) {

VkPresentModeKHR bestMode = VK_PRESENT_MODE_FIFO_KHR;

for (const auto& availablePresentMode : availablePresentModes) {

if (availablePresentMode == VK_PRESENT_MODE_MAILBOX_KHR)

{

return availablePresentMode;

} else if (availablePresentMode == VK_PRESENT_MODE_IMMEDIATE_KHR) {

bestMode = availablePresentMode;

}

}

return bestMode;

}

交换范围

现在只剩下一个属性需要设置了,我们添加一个叫做chooseSwapExtent的函数来设置它:

VkExtent2D chooseSwapExtent(const VkSurfaceCapabilitiesKHR &capabilities) {

}

交换范围是交换链中图像的分辨率,它几乎总是和我们要显示图像的窗口的分辨率相同。VkSurfaceCapabilitiesKHR结构体定义了可用的分辨率范围。Vulkan通过currentExtent成员变量来告知适合我们窗口的交换范围。一些窗口系统会使用一个特殊值,uint32_t变量类型的最大值,表示允许我们自己选择对于窗口最合适的交换范围,但我们选择的交换范围需要在minImageExtent与maxImageExtent的范围内。

VkExtent2D chooseSwapExtent(const VkSurfaceCapabilitiesKHR &capabilities) {

if (capabilities.currentExtent.width != std::numeric_limits<uint32_t>::max()) {

return capabilities.currentExtent;

} else {

VkExtent2D actualExtent = {WIDTH, HEIGHT};

actualExtent.width = std::max(capabilities.minImageExtent.width, std::min(capabilities.maxImageExtent.width, actualExtent.width));

actualExtent.height = std::max(capabilities.minImageExtent.height, std::min(capabilities.maxImageExtent.height, actualExtent.height));

return actualExtent;

}

}

代码中max和min函数用于在允许的范围内选择交换范围的高度值和宽度值,需要在源文件中包含algorithm头文件才能够使用它们。

创建交换链

现在,我们已经编写了大量辅助函数帮助我们在应用程序运行时选择最合适的设置,可以开始进行交换链的创建了。

我们添加一个叫做createSwapChain的函数,它会选择合适的交换链设置,然后,我们在initVulkan函数中在逻辑设备创建之后调用它:

void initVulkan() {

createInstance();

setupDebugCallback();

createSurface();

pickPhysicalDevice();

createLogicalDevice();

createSwapChain();

}

void createSwapChain() {

SwapChainSupportDetails swapChainSupport = querySwapChainSupport(physicalDevice);

VkSurfaceFormatKHR surfaceFormat = chooseSwapSurfaceFormat(swapChainSupport.formats);

VkPresentModeKHR presentMode = chooseSwapPresentMode(swapChainSupport.presentModes);

VkExtent2D extent = chooseSwapExtent(swapChainSupport.capabilities);

}

除了上面这些,还有一些地方需要我们进行设置,但这些设置都很简单,没有必要为它们编写独立的设置函数。这些设置包括交换链中的图像个数,也就是交换链的队列可以容纳的图像个数。我们使用交换链支持的最小图像个数+1数量的图像来实现三倍缓冲:

uint32_t imageCount = swapChainSupport.capabilities.minImageCount + 1;

if (swapChainSupport.capabilities.maxImageCount > 0 && imageCount > swapChainSupport.capabilities.maxImageCount) {

imageCount = swapChainSupport.capabilities.maxImageCount;

}

maxImageCount的值为0表明,只要内存可以满足,我们可以使用任意数量的图像。

和其它Vulkan对象相同,创建交换链对象需要填写一个包含大量信息的结构体。这一结构体的一些成员我们已经非常熟悉:

VkSwapchainCreateInfoKHR createInfo = {};

createInfo.sType = VK_STRUCTURE_TYPE_SWAPCHAIN_CREATE_INFO_KHR;

createInfo.surface = surface;

指定交换链绑定的表面后,我们还需要指定有关交换链图像的信息:

createInfo.minImageCount = imageCount;

createInfo.imageFormat = surfaceFormat.format;

createInfo.imageColorSpace = surfaceFormat.colorSpace;

createInfo.imageExtent = extent;

createInfo.imageArrayLayers = 1;

createInfo.imageUsage = VK_IMAGE_USAGE_COLOR_ATTACHMENT_BIT;

imageArrayLayers成员变量用于指定每个图像所包含的层次。通常,来说它的值为1。但对于VR相关的应用程序来说,会使用更多的层次。imageUsage成员变量用于指定我们将在图像上进行怎样的操作。在本教程,我们在图像上进行绘制操作,也就是将图像作为一个颜色附着来使用。如果读者需要对图像进行后期处理之类的操作,可以使用VK_IMAGE_USAGE_TRANSFER_DST_BIT作为imageUsage成员变量的值,让交换链图像可以作为传输的目的图像。

QueueFamilyIndices indices = findQueueFamilies(physicalDevice);

uint32_t queueFamilyIndices[] = {(uint32_t) indices.graphicsFamily, (uint32_t) indices.presentFamily};

if (indices.graphicsFamily != indices.presentFamily) {

createInfo.imageSharingMode = VK_SHARING_MODE_CONCURRENT;

createInfo.queueFamilyIndexCount = 2;

createInfo.pQueueFamilyIndices = queueFamilyIndices;

} else {

createInfo.imageSharingMode = VK_SHARING_MODE_EXCLUSIVE;

createInfo.queueFamilyIndexCount = 0; // Optional

createInfo.pQueueFamilyIndices = nullptr; // Optional

}

接着,我们需要指定在多个队列族使用交换链图像的方式。这一设置对于图形队列和呈现队列不是同一个队列的情况有着很大影响。我们通过图形队列在交换链图像上进行绘制操作,然后将图像提交给呈现队列来显示。有两种控制在多个队列访问图像的方式:

-

VK_SHARING_MODE_EXCLUSIVE:一张图像同一时间只能被一个队列族所拥有,在另一队列族使用它之前,必须显式地改变图像所有权。这一模式下性能表现最佳。

-

VK_SHARING_MODE_CONCURRENT:图像可以在多个队列族间使用,不需要显式地改变图像所有权。

如果图形和呈现不是同一个队列族,我们使用协同模式来避免处理图像所有权问题。协同模式需要我们使用queueFamilyIndexCount和pQueueFamilyIndices来指定共享所有权的队列族。如果图形队列族和呈现队列族是同一个队列族(大部分情况下都是这样),我们就不能使用协同模式,协同模式需要我们指定至少两个不同的队列族。

createInfo.preTransform = swapChainSupport.capabilities.currentTransform;

我们可以为交换链中的图像指定一个固定的变换操作(需要交换链具有supportedTransforms特性),比如顺时针旋转90度或是水平翻转。如果读者不需要进行任何变换操作,指定使用currentTransform变换即可。

createInfo.compositeAlpha = VK_COMPOSITE_ALPHA_OPAQUE_BIT_KHR;

compositeAlpha成员变量用于指定alpha通道是否被用来和窗口系统中的其它窗口进行混合操作。通常,我们将其设置为VK_COMPOSITE_ALPHA_OPAQUE_BIT_KHR来忽略掉alpha通道。

createInfo.presentMode = presentMode;

createInfo.clipped = VK_TRUE;

presentMode成员变量用于设置呈现模式。clipped成员变量被设置为VK_TRUE表示我们不关心被窗口系统中的其它窗口遮挡的像素的颜色,这允许Vulkan采取一定的优化措施,但如果我们回读窗口的像素值就可能出现问题。

createInfo.oldSwapchain = VK_NULL_HANDLE;

最后是oldSwapchain成员变量,需要指定它,是因为应用程序在运行过程中交换链可能会失效。比如,改变窗口大小后,交换链需要重建,重建时需要之前的交换链,具体细节,我们会在之后的章节详细介绍。现在,我们还没有创建任何一个交换链,将它设置为VK_NULL_HANDLE即可。 添加一个VkSwapchainKHR成员变量来存储交换链:

VkSwapchainKHR swapChain;

调用vkCreateSwapchainKHR函数创建交换链:

if (vkCreateSwapchainKHR(device, &createInfo, nullptr, &swapChain) != VK_SUCCESS) {

throw std::runtime_error("failed to create swap chain!");

}

vkCreateSwapchainKHR函数的参数依次是逻辑设备对象,交换链创建信息,可选的自定义内存分配器和用于存储返回的交换链对象的内存地址。接着,我们需要在cleanup函数中在逻辑设备被清除前调用vkDestroySwapchainKHR函数来清除交换链对象:

void cleanup() {

vkDestroySwapchainKHR(device, swapChain, nullptr);

...

}

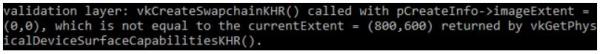

现在可以编译运行程序,确保我们成功地创建了交换链。如果vkCreateSwapchainKHR函数调用出现错误,那么,就移除createInfo.imageExtent=extent;这行代码,然后,启用校验层,编译运行程序,就可以捕获错误,得到一些有用地信息:

获取交换链图像

我们已经创建了交换链,接下来需要做地就是获取交换链图像的图像句柄。我们会在之后使用这些图像句柄进行渲染操作。现在,添加成员变量用于存储这些图像句柄:

std::vector<VkImage> swapChainImages

交换链图像由交换链自己负责创建,并在交换链清除时自动被清除,不需要我们自己进行创建和清除操作。

我们在createSwapChain函数的尾部,vkCreateSwapchainKHR函数调用之后,添加代码来获取交换链图像句柄。获取它们的方法和获取其它Vulkan对象的方法类似,首先获取交换链图像的数量,然后分配数组空间,获取交换链图像句柄。

vkGetSwapchainImagesKHR(device, swapChain, &imageCount, nullptr);

swapChainImages.resize(imageCount);

vkGetSwapchainImagesKHR(device, swapChain, &imageCount, swapChainImages.data());

我们在创建交换链时指定了一个minImageCount成员变量来请求最小需要的交换链图像数量。Vulkan的具体实现可能会创建比这个最小交换链图像数量更多的交换链图像,我们在这里,我们仍然需要显式地查询交换链图像数量,确保不会出错。

最后,在成员变量中存储我们设置的交换链图像格式和范围,我们会在之后的章节使用它们。

VkSwapchainKHR swapChain;

std::vector<VkImage> swapChainImages;

VkFormat swapChainImageFormat;

VkExtent2D swapChainExtent;

...

swapChainImageFormat = surfaceFormat.format;

swapChainExtent = extent;

现在,我们已经拥有了可以进行绘制操作的交换链图像,以及可以呈现图像的窗口表面。从下一章节开始,我们开始真正的图形管线部分。

本章节代码:

C++:

https://vulkan-tutorial.com/code/06_swap_chain_creation.cpp

图像视图

使用任何VkImage对象,包括处于交换链中的,处于渲染管线中的,都需要我们创建一个VkImageView对象来绑定访问它。图像视图描述了访问图像的方式,以及图像的哪一部分可以被访问。比如,图像可以被图像视图描述为一个没有细化级别的二维深度纹理,进而可以在其上进行与二维深度纹理相关的操作。

在本章节,我们编写了一个叫做createImageViews的函数来为交换链中的每一个图像建立图像视图。

首先,添加用于存储图像视图的成员变量:

std::vector<VkImageView> swapChainImageViews;

然后,添加createImageViews函数,并在initVulkan函数调用createSwapChain函数创建交换链之后调用它:

void initVulkan() {

createInstance();

setupDebugCallback();

createSurface();

pickPhysicalDevice();

createLogicalDevice();

createSwapChain();

createImageViews();

}

void createImageViews() {

}

接着,我们分配足够的数组空间来存储图像视图:

void createImageViews() {

swapChainImageViews.resize(swapChainImages.size());

}

遍历所有交换链图像,创建图像视图:

for (size_t i = 0; i < swapChainImages.size(); i++) {

}

图像视图的创建需要我们填写VkImageViewCreateInfo结构体:

VkImageViewCreateInfo createInfo = {};

createInfo.sType = VK_STRUCTURE_TYPE_IMAGE_VIEW_CREATE_INFO;

createInfo.image = swapChainImages[i];

viewType和format成员变量用于指定图像数据的解释方式。viewType成员变量用于指定图像被看作是一维纹理、二维纹理、三维纹理还是立方体贴图。

createInfo.viewType = VK_IMAGE_VIEW_TYPE_2D;

createInfo.format = swapChainImageFormat;

components成员变量用于进行图像颜色通道的映射。比如,对于单色纹理,我们可以将所有颜色通道映射到红色通道。我们也可以直接将颜色通道的值映射为常数0或1。在这里,我们只使用默认的映射:

createInfo.components.r = VK_COMPONENT_SWIZZLE_IDENTITY;

createInfo.components.g = VK_COMPONENT_SWIZZLE_IDENTITY;

createInfo.components.b = VK_COMPONENT_SWIZZLE_IDENTITY;

createInfo.components.a = VK_COMPONENT_SWIZZLE_IDENTITY;

subresourceRange成员变量用于指定图像的用途和图像的哪一部分可以被访问。在这里,我们的图像被用作渲染目标,并且没有细分级别,只存在一个图层:

createInfo.subresourceRange.aspectMask = VK_IMAGE_ASPECT_COLOR_BIT;

createInfo.subresourceRange.baseMipLevel = 0;

createInfo.subresourceRange.levelCount = 1;

createInfo.subresourceRange.baseArrayLayer = 0;

createInfo.subresourceRange.layerCount = 1;

如果读者在编写VR一类的应用程序,可能会使用支持多个层次的交换链。这时,读者应该为每个图像创建多个图像视图,分别用来访问左眼和右眼两个不同的图层。

调用vkCreateImageView函数创建图像视图:

if (vkCreateImageView(device, &createInfo, nullptr, &swapChainImageViews[i]) != VK_SUCCESS) {

throw std::runtime_error("failed to create image views!");

}

和交换链图像不同,图像视图是由我们自己显式创建的,需要我们自己在cleanup函数中清除它们:

void cleanup() {

for (auto imageView : swapChainImageViews) {

vkDestroyImageView(device, imageView, nullptr);

}

...

}

有了图像视图,就可以将图像作为纹理使用,但作为渲染目标,还需要帧缓冲对象。接下来的章节,我们会简要介绍渲染管线,然后介绍帧缓冲对象。

本章节代码:

C++:

https://vulkan-tutorial.com/code/07_image_views.cpp

图形管线概述

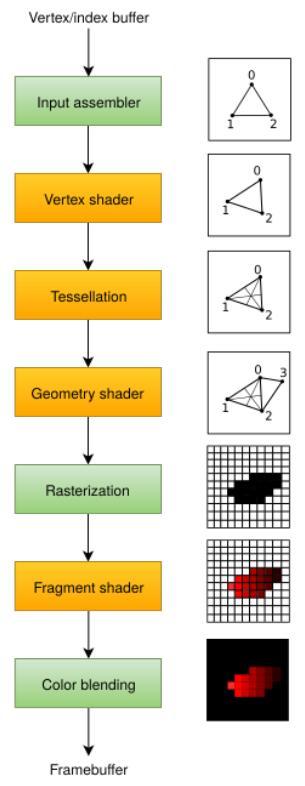

在接下来的章节,我们将开始配置图形管线来渲染我们的三角形。图形管线是一系列将我们提交的顶点和纹理转换为渲染目标上的像素的操作。它的简化过程如下:

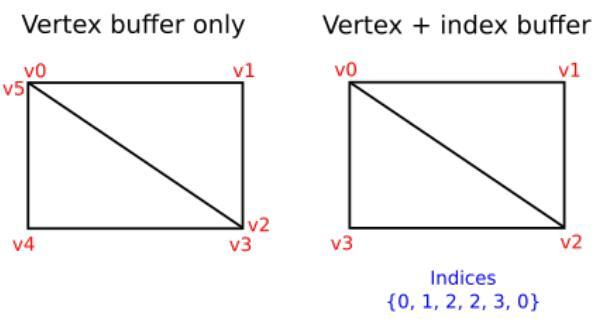

input assembler获取顶点数据,顶点数据的来源可以是应用程序提交的原始顶点数据,或是根据索引缓冲提取的顶点数据。

vertex shader对每个顶点进行模型空间到屏幕空间的变换,然后将顶点数据传递给图形管线的下一阶段。

tessellation shaders根据一定的规则对几何图形进行细分,从而提高网格质量。通常被用来使类似墙面这类不光滑表面看起来更自然。

geometry shader可以以图元(三角形,线段,点)为单位处理几何图形,它可以剔除图元,输出图元。有点类似于tessellation shader,但更灵活。但目前已经不推荐应用程序使用它,geometry shader的性能在除了Intel集成显卡外的大多数显卡上表现不佳。

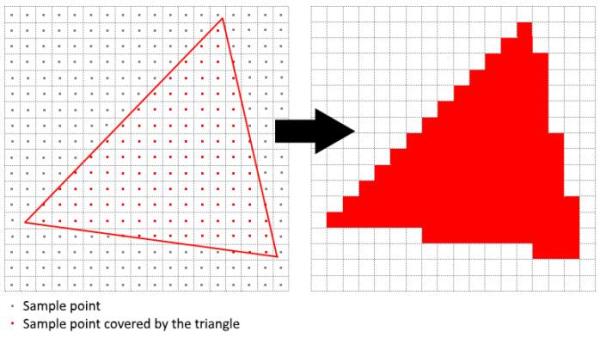

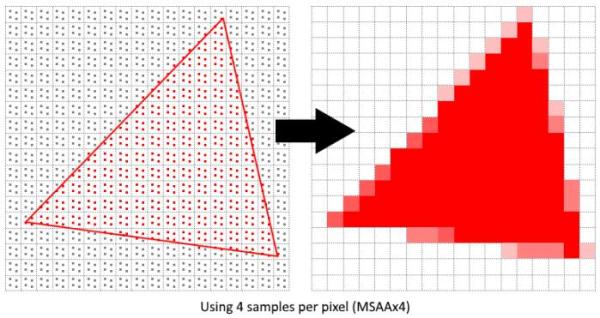

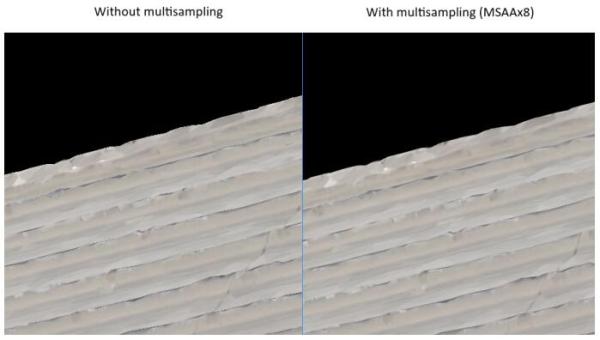

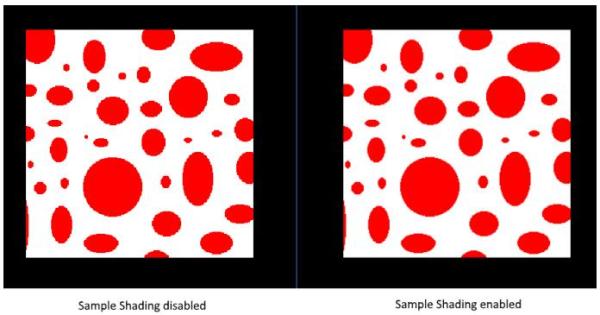

rasterization阶段将图元离散为片段。片段被用来在帧缓冲上填充像素。位于屏幕外的片段会被丢弃,顶点着色器输出的顶点属性会在片段之间进行插值,开启深度测试后,位于其它片段之后的片段也会被丢弃。

fragment shader对每一个未被丢弃的片段进行处理,确定片段要写入的帧缓冲,它可以使用来自vertex shader的插值数据,比如纹理坐标和顶点法线。

color blending阶段对写入帧缓冲同一像素位置的不同片段进行混合操作。片段可以直接覆盖之前写入的片段,也可以基于之前片段写入的信息进行混合操作。

使用绿色标识的阶段也被叫做固定功能阶段。固定功能阶段允许通过参数对处理过程进行一定程度的配置。

使用橙色标识的阶段是可编程阶段,允许我们将自己的代码加载到显卡,进行我们想要的操作。这使得我们可以实现许多有趣的效果。我们加载到显卡的代码会被GPU并行处理。

如果读者使用了一些旧的图形API,可能会对glBlendFunc和OMSetBlendState之类的函数比较熟悉,这些函数可以对图形管线进行一定的设置。而在Vulkan中,图形管线几乎完全不允许进行动态设置,如果我们想使用其它着色器,绑定其它帧缓冲,以及改变混合函数,都需要重新创建管线。这就迫使我们必须提前创建所有我们需要使用的图形管线,虽然这样看起来不太方便,但这给驱动程序带来了很大的优化空间。

图形管线的部分可编程阶段不是必需的。比如对于tessellation和geometry shader阶段,如果我们只是画一个简单的三角形,完全没有必要使用它们。如果我们只是需要生成阴影贴图的深度值,我们也可以不使用fragment shader。

在下一章节,我们首先创建两个对于在屏幕上绘制三角形必需的可编程阶段:vertex shader和fragment shader。对于固定功能的设置,比如混合模式,视口,光栅化会在下一章节之后进行。最后,我们开始图形管线中帧缓冲的配置工作。

我们添加一个叫做createGraphicsPipeline的函数,并在initVulkan函数中的createImageViews函数调用之后调用它。接下来的章节我们主要在createGraphicsPipeline这个函数中进行代码编写。

void initVulkan() {

createInstance();

setupDebugCallback();

createSurface();

pickPhysicalDevice();

createLogicalDevice();

createSwapChain();

createImageViews();

createGraphicsPipeline();

}

...

void createGraphicsPipeline() {

}

本章节代码:

C++:

https://vulkan-tutorial.com/code/08_graphics_pipeline.cpp

着色器模块

和之前的一些图形API不同,Vulkan使用的着色器代码格式是一种叫做SPIR-V的字节码,这一字节码格式可以在Vulkan和OpenCL上使用。可以用它来编写图形和计算着色器,在本教程,我们将它用于编写图形管线的着色器。

GPU厂商的编译器将字节码转换为原生代码的工作复杂度远远低于直接编译较高级的类C代码。过去的经验告诉我们使用类C代码,比如GLSL作为着色器代码,会因为不同GPU厂商对代码的不同解释而造成大量问题,并且类C代码的编译器实现要比字节码编译器复杂的多,GPU厂商实现的编译器也极有可能存在错误,不同GPU厂商的实现也差异巨大。而使用字节码格式,上述的这些问题可以在极大程度上减少。

虽然,Vulkan使用字节码格式作为着色器代码,但这并不意味着我们要直接书写字节码来编写着色器。Khronos发布了一个独立于厂商的可以将GLSL代码转换为SPIR-V字节码的编译器。这个编译器可以验证我们的着色器代码是否完全符合标准,将GLSL代码转换为SPIR-V字节码。我们可以在应用程序运行时调用这个编译器,动态生成SPIR-V字节码,但在本教程,我们没有这样做。这一编译器已经被包含在了LunarG的Vulkan SDK中,编译器可执行文件名称为glslangValidator.exe,不需要读者另外下载。

GLSL是一个类C的着色器语言。使用GLSL编写的程序包含了一个main函数,这一函数完成具体的运算操作。GLSL使用全局变量进行输入输出,它包含了许多用于图形编程的特性,比如向量和矩阵支持,用于计算叉积的函数,用于矩阵与向量相乘的函数,用于计算反射向量的函数等等。GLSL中的向量类型叫做vec,后跟一个表示向量元素数的数字。比如,用于表示一个三维空间位置的向量的类型为vec3。GLSL允许我们访问向量的分量比如.x,也允许我们使用表达式来创建新的向量值,比如vec3(1.0, 2.0, 3.0).xy会返回一个vec2类型的值。向量构造器也可以被组合使用,比如可以使用vec3(vec2(1.0, 2.0), 3.0)生成一个vec3类型的值。

之前的章节提到,我们需要编写顶点着色器和片段着色器才能完成在屏幕上绘制三角形的工作。接下来的两节的内容就是使用GLSL编写顶点着色器和片段着色器代码,然后使用编译器将它们转换为SPIR-V字节码。

顶点着色器

顶点着色器对输入的每个顶点进行处理。它可以接收顶点属性作为输入,比如世界坐标,颜色,法线和纹理坐标。它的输出包括顶点最终的裁剪坐标和需要传递给片段着色器的顶点属性,比如颜色和纹理坐标。这些值会被插值处理后传给顶点着色器。

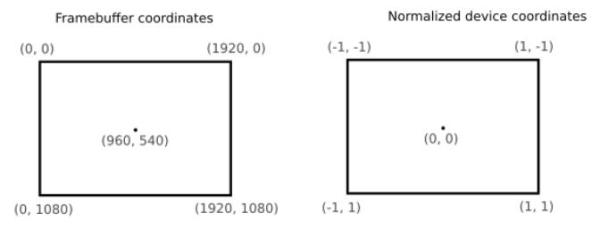

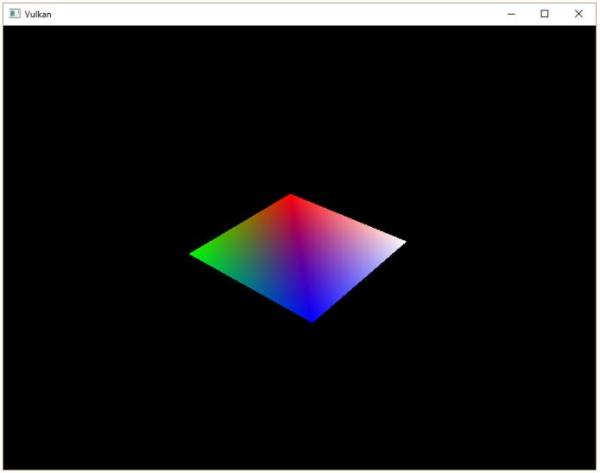

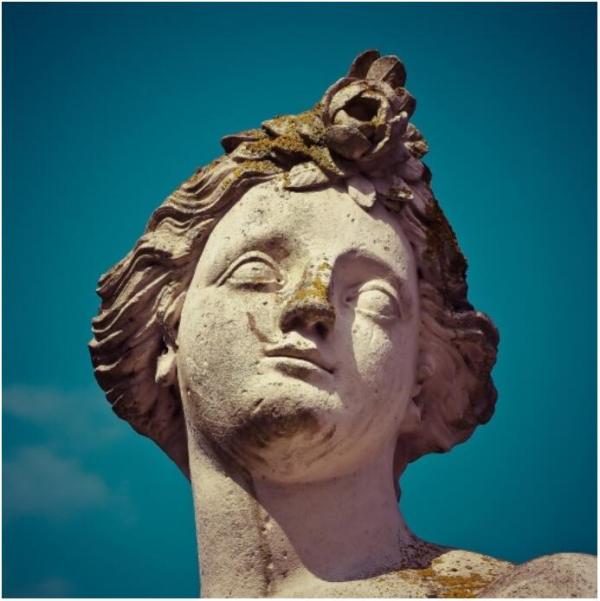

裁剪坐标是一个来自顶点着色器的四维向量,它的四个成分会被除以第四个成分来完成规范化。规范化后的坐标被映射到帧缓冲的坐标空间,如下图所示:

如果读者对计算机图形学有所了解,应该对此比较熟悉。如果读者之前使用过OpenGL,可能会注意到这里的Y坐标和OpenGL的Y坐标是相反方向的,Z坐标现在的范围和Direct3D相同,为0到1。

对于我们的要绘制的三角形,不需要使用任何变换操作,我们直接将三角形的三个顶点的坐标作为规范化设备坐标来生成下图的三角形:

我们可以直接将顶点着色器输出的裁剪坐标的第四个成分设置为1,然后作为规范设备坐标。这样裁剪坐标到规范设备坐标就不会对坐标进行任何变换。

通常,顶点坐标被存储在一个顶点缓冲中,但对于Vulkan来说,创建顶点缓冲,然后填入数据要进行很多操作。为了尽快让我们的三角形显示在屏幕上,我们暂时先直接将顶点坐标写入顶点着色器,就像这样:

#version 450

#extension GL_ARB_separate_shader_objects : enable

out gl_PerVertex {

vec4 gl_Position;

};

vec2 positions[3] = vec2[](

vec2(0.0, -0.5),

vec2(0.5, 0.5),

vec2(-0.5, 0.5)

);

void main() {

gl_Position = vec4(positions[gl_VertexIndex], 0.0, 1.0);

}

着色器的main函数对于每个顶点执行一次。GLSL内建的gl_VertexIndex变量包含了当前顶点的索引。这一索引通常来说是用来引用顶点缓冲中的顶点数据,但在这里,我们用它来引用我们在着色器中硬编码的顶点数据。我们输出的裁剪坐标由代码中的positions数组给出了前两个成分,剩余两个成分被我们设置为了0.0和1.0。为了让着色器代码可以在Vulkan下工作,我们需要使用GL_ARB_separate_shader_objects扩展。

片段着色器

我们的三角形由来自顶点着色器的三个顶点作为三角形的顶点构成,这一三角形范围内的屏幕像素会被使用片段着色器处理后的片段进行填充。一个非常简单的直接将片段颜色设置为红色的片段着色器代码如下所示:

#version 450

#extension GL_ARB_separate_shader_objects : enable

layout(location = 0) out vec4 outColor;

void main() {

outColor = vec4(1.0, 0.0, 0.0, 1.0);

}

对于每个片段着色器的main函数执行一次。GLSL下的颜色是一个具有四个分量的向量,分别对应R,G,B和Alpha通道,分量的取值范围为[0,1]。和顶点着色器不同,片段着色器没有类似gl_Position这样的内建变量可以用于输出当前处理的片段的颜色。我们必须自己为每个使用的帧缓冲指定对应的输出变量。上面代码中的layout(location=0)用于指定与颜色变量相关联的帧缓冲,颜色变量的颜色数据会被写入与它相关联的帧缓冲中。上面的代码,我们将红色写入和索引为0的帧缓冲相关联的颜色变量outColor。

逐顶点着色

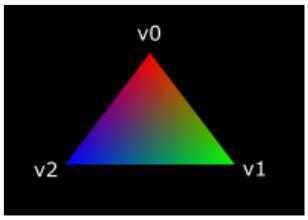

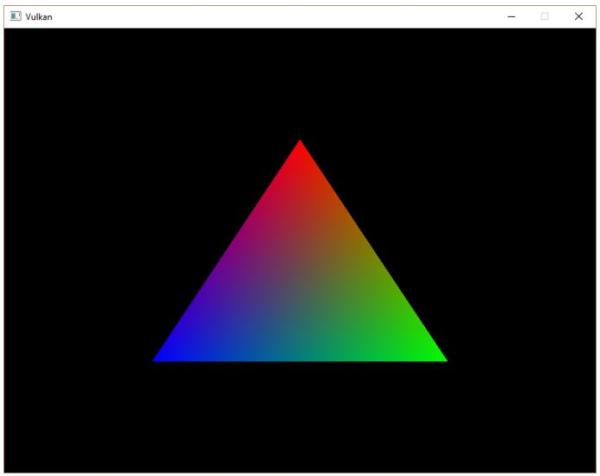

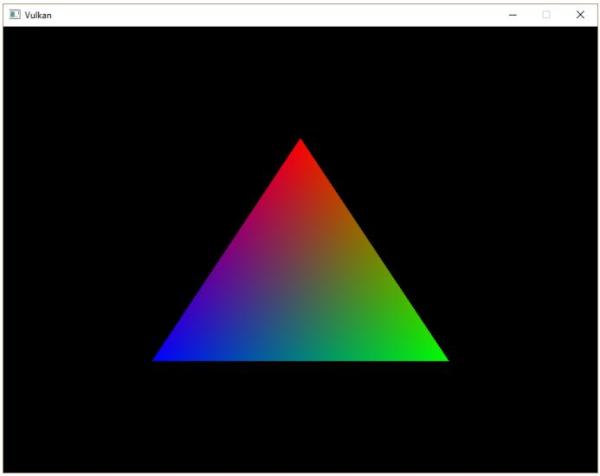

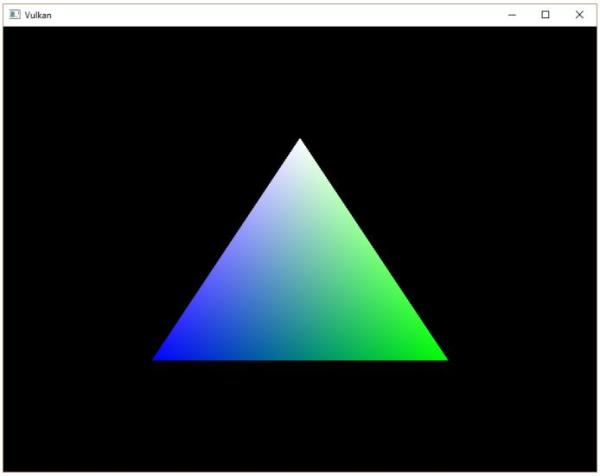

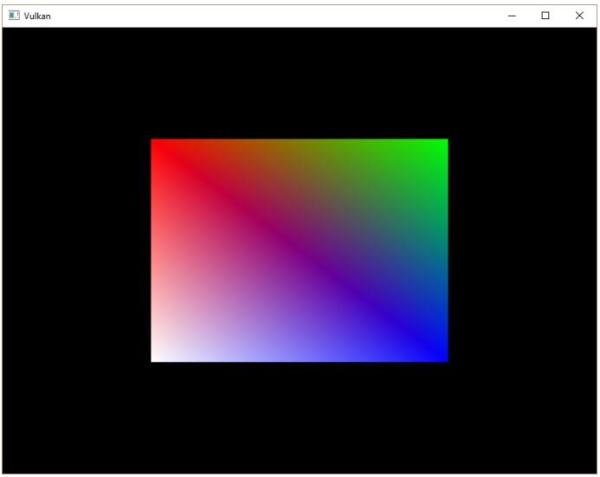

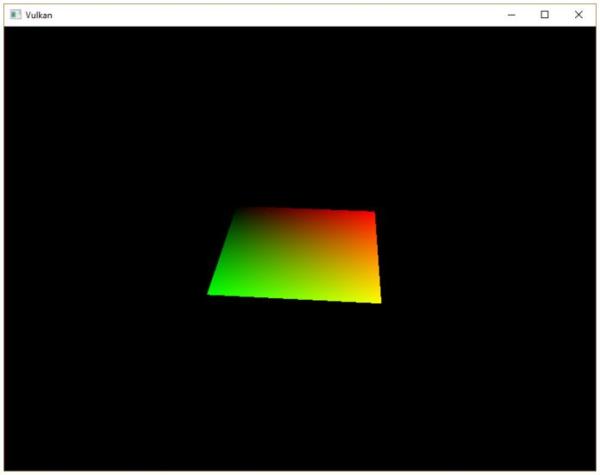

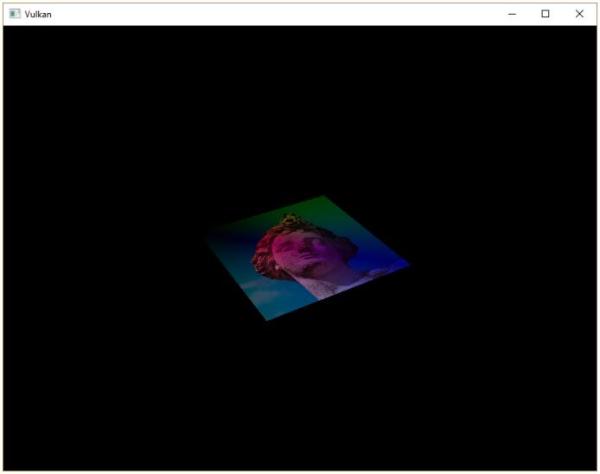

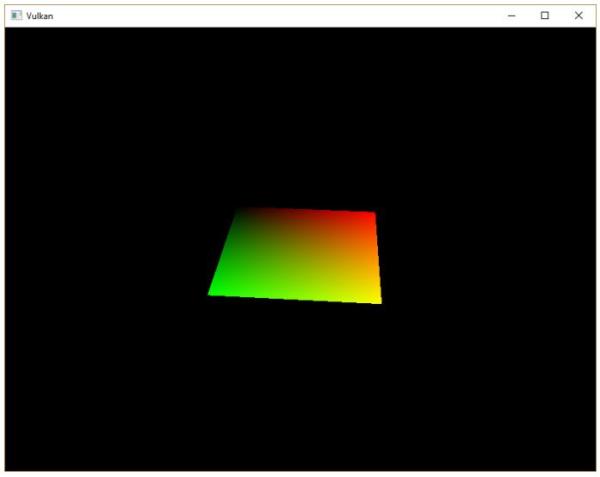

整个三角形都是红色,看上去一点都不好玩,接下来,让我们尝试把三角形变成下面这个样子:

我们需要对之前编写的顶点着色器和片段着色器进行修改才能得到上图的效果。首先,我们需要为三角形的每个顶点指定不同的颜色,我们在顶点着色器中添加一个颜色数组:

vec3 colors[3] = vec3[](

vec3(1.0, 0.0, 0.0),

vec3(0.0, 1.0, 0.0),

vec3(0.0, 0.0, 1.0)

);

现在,我们只需要将顶点的颜色传递给片段着色器,由片段着色器将颜色值输出到帧缓冲上。在顶点着色器中添加颜色输出变量,并在main函数中写入颜色值到颜色输出变量:

layout(location = 0) out vec3 fragColor;

void main() {

gl_Position = vec4(positions[gl_VertexIndex], 0.0, 1.0);

fragColor = colors[gl_VertexIndex];

}

接着,我们在片段着色器中添加对应的输入变量:

layout(location = 0) in vec3 fragColor;

void main() {

outColor = vec4(fragColor, 1.0);

}

一组对应的输入和输出变量可以使用不同的变量名称,编译器可以通过定义它们时使用的location将它们对应起来。片段着色器的main函数现在被我们修改为输出输入的颜色变量作为片段颜色。三角形除了顶点之外的片段颜色会被插值处理。

编译着色器

现在,让我们在项目目录下创建一个叫做shaders的文件夹,然后在其中添加一个叫做shader.vert的保存有顶点着色器代码的文件,以及一个叫做shader.frag的保存有片段着色器代码的文件。GLSL并没有规定着色器文件应该使用的扩展名称,上面使用的扩展名名称来源于习惯。

shader.vert文件的内容如下:

#version 450

#extension GL_ARB_separate_shader_objects : enable

out gl_PerVertex {

vec4 gl_Position;

};

layout(location = 0) out vec3 fragColor;

vec2 positions[3] = vec2[](

vec2(0.0, -0.5),

vec2(0.5, 0.5),

vec2(-0.5, 0.5)

);

vec3 colors[3] = vec3[](

vec3(1.0, 0.0, 0.0),

vec3(0.0, 1.0, 0.0),

vec3(0.0, 0.0, 1.0)

);

void main() {

gl_Position = vec4(positions[gl_VertexIndex], 0.0, 1.0);

fragColor = colors[gl_VertexIndex];

}

shader.frag文件的内容如下:

#version 450

#extension GL_ARB_separate_shader_objects : enable

layout(location = 0) in vec3 fragColor;

layout(location = 0) out vec4 outColor;

void main() {

outColor = vec4(fragColor, 1.0);

}

接下来,我们使用glslangValidator来将着色器代码编译为SPIR-V字节码格式。

Windows

创建一个compile.bat文件,它的内容如下:

C:/VulkanSDK/1.0.17.0/Bin32/glslangValidator.exe -V shader.vert

C:/VulkanSDK/1.0.17.0/Bin32/glslangValidator.exe -V shader.frag

pause

读者需要将上面代码中glslangValidator.exe的文件路径替换为自己的glslangValidator.exe所在的文件路径。双击运行这个文件,就可以完成着色器代码的编译。

Linux

创建一个compile.sh文件,它的内容如下:

/home/user/VulkanSDK/x.x.x.x/x86_64/bin/glslangValidator -V shader.vert

/home/user/VulkanSDK/x.x.x.x/x86_64/bin/glslangValidator -V shader.frag

读者需要将上面代码中glslangValidator的文件路径替换为自己的glslangValidator所在的文件路径。然后在终端中使用chmod +x compile.sh给予它可执行的权限,最后运行它。

以下部分与平台无关

上面我们使用两行代码使用-V选项调用编译器,将GLSL着色器代码文件转换为SPIR-V字节码格式。运行脚本后,读者可以在当前文件夹下看到两个新的文件vert.spv和frag.spv。这两个文件的文件名由编译器自动推导出来,读者可以使用自己喜欢的名称重命名这两个文件。编译脚本的执行过程中可能出现一些缺少特性的警告,读者可以放心地忽略掉这些警告。

如果着色器代码存在语法错误,编译器会报告语法错误所在的行,以及错误出现的原因。读者可以尝试去掉某行着色器代码的分号,让编译器检查这一语法错误,熟悉编译器的报错信息的。也可以尝试不使用任何选项调用编译器来查看编译器支持的选项种类。此外,编译器还支持将SPIR-V格式的字节码反向编译为便于人类阅读的代码格式。

载入着色器

我们已经得到了SPIR-V格式的着色器字节码文件,现在需要在应用程序中载入字节码文件。为了完成这项工作,我们首先编写一个用于载入二进制文件的辅助函数。

#include <fstream>

...

static std::vector<char> readFile(const std::string& filename) {

std::ifstream file(filename, std::ios::ate | std::ios::binary);

if (!file.is_open()) {

throw std::runtime_error("failed to open file!");

}

}

readFile函数会读取指定文件的所有字节,然后将数据保存在std::vector数组返回给调用者。上面代码中我们使用了下面两个模式打开文件:

-

ate:从文件尾部开始读取

-

binary:以二进制的形式读取文件(避免进行诸如行末格式是\n还是\r\n的转换)

使用ate模式,从文件尾部开始读取的原因是,我们可以根据读取位置确定文件的大小,然后分配足够的数组空间来容纳数据:

size_t fileSize = (size_t) file.tellg();

std::vector<char> buffer(fileSize);

分配好足够的数组空间后,我们可以跳到文件头部,读取整个文件:

file.seekg(0);

file.read(buffer.data(), fileSize);

最后,关闭文件,返回数据数组:

file.close();

return buffer;

现在,我们可以在createGraphicsPipeline函数中调用readFile函数来完成着色器字节码的读取:

void createGraphicsPipeline() {

auto vertShaderCode = readFile("shaders/vert.spv");

auto fragShaderCode = readFile("shaders/frag.spv");

}

我们可以通过比较打印出的分配的数组大小和实际的文件大小,确保着色器字节码被正确载入。

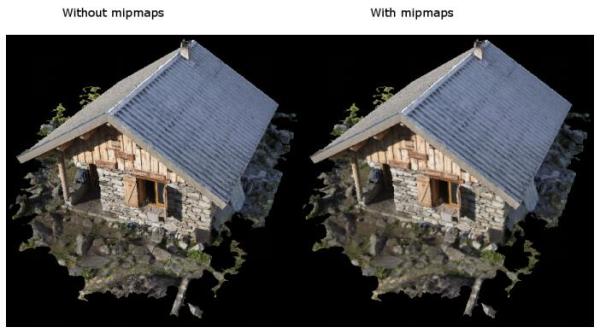

创建着色器模块